Apple vai analisar fotos de iPhones e iCloud para combater abuso de menores

Com recursos de IA, Apple pretende ajudar no combate ao abuso infantil; sistema também terá moderação humana, mas enfrenta críticas

Com recursos de IA, Apple pretende ajudar no combate ao abuso infantil; sistema também terá moderação humana, mas enfrenta críticas

A Apple anunciou a implementação de um novo sistema que pretende ajudar a combater abuso de menores a partir da análise de fotos de iPhones armazenadas no iCloud. O recurso é um dos esforços que a empresa está apresentando com o foco em proteção para crianças, e usará algoritmos treinados para identificar Material de Abuso Infantil (o que a companhia chamou de “CSAM”, na sigla em inglês) — na prática, esse material consiste em conteúdo que revele atividades sexualmente explícitas envolvendo crianças.

A empresa alega que o processo é seguro e foi pensado de modo a preservar a privacidade dos usuários. Segundo a Apple, as garantias são de que ela não armazena nenhum tipo de conhecimento baseado em imagens que não correspondam ao banco de dados referente ao CSAM, fornecidas pelo Centro Nacional para Crianças Desaparecidas e Exploradas dos EUA.

Além disso, a companhia diz que “o risco de o sistema sinalizar incorretamente uma conta extremamente baixo”, mais especificamente, menos de 1 em 1 trilhão de contas por ano poderiam ser sinalizadas indevidamente. Ainda assim, a empresa irá contar com análise manual de todos os alertas que virarem relatórios para as autoridades, com o intuito de evitar erros de IA.

Os usuários não têm acesso ao banco de dados de CSAM e também não são avisados sobre conteúdo que foi sinalizado como CSAM pelo sistema da Apple.

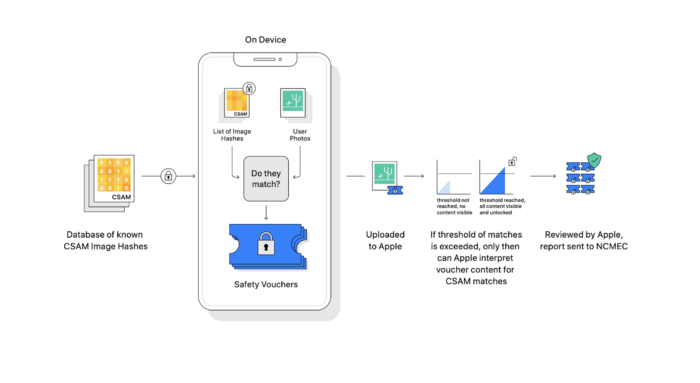

Sistema da Apple pretende analisar fotos do iPhone salvas no iCloud (Imagem: Reprodução/Apple)

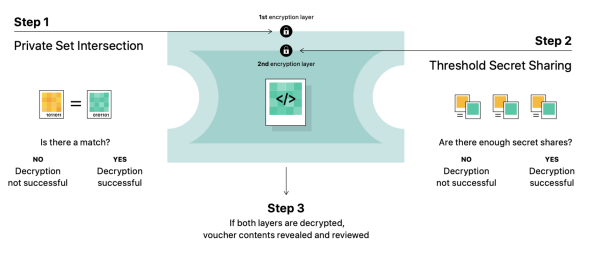

A explicação dada pela Apple diz, em termos práticos, que antes de uma imagem ser armazenada no iCloud, ela passa por um processo de correspondência no próprio dispositivo. A ação procura padrões e os compara a um conjunto ilegível de hashes de conteúdo CSAM conhecido — tudo isso coberto por criptografia. Imagens salvas apenas localmente não passam por esse processo.

Desse modo, é possível para a Apple identificar se um hash de imagem corresponde a um hash do banco de dados sem de fato adquirir conhecimento sobre qualquer outro aspecto do conteúdo.

Se o processo der match, o dispositivo irá codificar o resultado positivo. Esses resultados não podem ser interpretados pela Apple até que a conta do iCloud ultrapasse um limite estabelecido de resultados positivos — o número não foi divulgado pela empresa.

Somente quando há vários padrões identificados, um relatório é emitido (Imagem: Reprodução/Apple)

Ao chegar no limite, a Apple deverá analisar de forma manual o relatório para confirmar o resultado e poderá bloquear a conta do usuário, enviando também um relatório ao Centro Nacional para Crianças Desaparecidas e Exploradas.

Uma ferramenta que irá escanear todo o conteúdo que você armazena no iCloud Photos, ainda que com a promessa de privacidade, levanta diversas questões e críticas.

Em primeiro lugar, a mera possibilidade de o recurso entrar em prática nos faz questionar: e se não fosse a Apple, mas alguma autoridade governamental por trás do sistema? Qual é a garantia de que isso não possa ser uma porta para algo muito mais ambicioso e complexo, que caindo em mãos erradas, pode levar até à perseguição de pessoas?

Como o especialista em criptografia Matthew Green ressalta no Twitter, ainda que a Apple faça um “bom uso” da ferramenta, o banco de dados usado pela empresa não pode ser verificado pelo consumidor. Não há como ter certeza sobre que está sendo usado como padrão. Vale lembrar que a Apple pode ter desistido de usar criptografia de ponta a ponta no backup do iCloud por pressão do FBI, o que coloca em dúvida sobre até onde vai o apreço pela privacidade pregado pela empresa.

Além disso, o sistema pode acusar falso-positivo, já que justamente para buscar maior eficiência, os parâmetros utilizados na análise não funcionam como um código perfeito imutável para cada imagem — o sistema é capaz de ler e interpretar diferentes sinalizações para detectar alterações em conteúdo potencialmente prejudicial. Isso quer dizer também que há chances de um conteúdo perfeitamente “limpo” ser classificado como abusivo por engano.

Por fim, há uma questão ainda mais problemática: o sistema pode ser explorado por pessoas mal intencionadas para prejudicar terceiros sem o seu conhecimento. Como hashes inofensivos podem coincidir com padrões do banco CSAM da Apple, é possível que alguém crie também propositalmente um arquivo que poderia ser compartilhado sem nenhum problema visual, mas que tenha um hash problemático.

A ação poderia fazer com que uma pessoa ou um grupo de pessoas seja notado pela ferramenta da Apple — o que, em um limite que não conhecemos, poderia levar à suspensão da conta, causando diversos transtornos.

Por enquanto, a empresa não fez nenhuma declaração sobre as críticas. Mas à luz dos novos recursos, resta saber como a Apple pretende contornar os alertas levantados.

Inicialmente, o sistema chega para usuários nos Estados Unidos, mas a companhia tem planos para expandir o recurso para outros países.