Apple escaneia e-mails no iCloud para combater abuso de menores

Sistema para identificar imagens de abuso sexual infantil já era utilizado em e-mails do iCloud, mas não em fotos e backups na nuvem

Sistema para identificar imagens de abuso sexual infantil já era utilizado em e-mails do iCloud, mas não em fotos e backups na nuvem

A polêmica envolvendo a ferramenta para vasculhar fotos do iPhones e do iCloud para combater o abuso infantil ganhou mais um episódio. A Apple confirmou que analisa e-mails da plataforma para identificar Material de Abuso Infantil (CSAM, em inglês) há alguns anos. A prática, porém, não era aplicada às fotos e aos backups do serviço na nuvem. As informações foram reveladas pelo 9to5Mac nesta segunda-feira (23).

A confirmação parte de um questionamento devido a uma declaração recente sobre o assunto. Na semana passada, um executivo da fabricante do iPhone informou que seus produtos são “a melhor plataforma para distribuir pornografia infantil”. Em seguida, o site entrou em contato com a empresa para saber como eles, de fato, sabem disso.

Ao 9to5Mac, a Apple confirmou que verifica os anexos de mensagens enviadas e recebidas do iCloud desde 2019. A prática acontece no serviço de e-mail para encontrar vestígios de CSAM, assim como proposto para a plataforma de fotos. Mas este não é o único meio: a empresa ainda informou que faz uma varredura limitada de outros dados, em uma “escala minúscula”, sem especificar que tipos de informações seriam essas.

Além disso, um documento arquivado da Apple, conhecido como “Nosso compromisso com a segurança infantil”, deu mais detalhes sobre a prática:

“Como parte desse compromisso [para combater o abuso de menores], a Apple usa a tecnologia de correspondência de imagens para ajudar a encontrar e denunciar a exploração infantil. Assim como os filtros de spam em e-mail, nossos sistemas usam assinaturas eletrônicas para localizar suspeitas de exploração infantil. Nós validamos cada combinação com revisão individual”.

Ainda assim, a fabricante do iPhone ressaltou ao site especializado que nunca escaneou fotos e cópias de segurança guardados no iCloud.

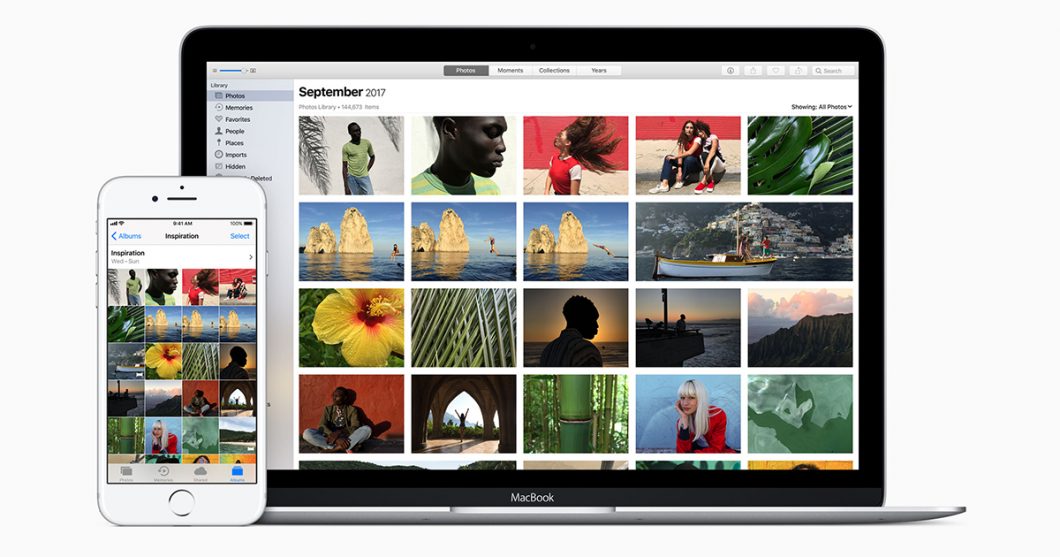

A solução para encontrar CSAM veio à tona no começo de agosto. A companhia anunciou, na época, um sistema capaz de vasculhar fotos do iCloud para monitorar pornografia infantil a fim de combater o abuso de menores. Isto seria possível graças a algoritmos treinados para identificar esse tipo de conteúdo guardado na plataforma.

A iniciativa, porém, tornou-se alvo de críticas e preocupações desde o seu surgimento. Segundo a Apple, o recurso é seguro e preserva a privacidade dos usuários. Além disso, o sistema trata apenas de conteúdos relacionados ao banco de dados fornecido pelo Centro Nacional para Crianças Desaparecidas e Exploradas dos EUA.

Mas isto não foi o suficiente para passar confiança absoluta a todos. Afinal, todo conteúdo armazenado no iCloud Photos será escaneado pela ferramenta.

Um dos alertas partem do especialista em criptografia Matthew Green. Pelo Twitter no último dia 4, ele ressaltou que o usuário não tem acesso o banco de dados utilizado pela companhia. Além disso, existe o risco de o sistema acusar um falso-negativo ou até mesmo ser utilizado por pessoas mal intencionadas.

Demais indagações partiram do chefe do WhatsApp, Will Cathcart. O executivo afirmou, em 6 de agosto, que o leitor pode ser usado por governos. Ele também ressaltou que a solução para vasculhar fotos não será implementado no mensageiro do Facebook.

O vice-presidente sênior de engenharia de software da Apple, Craig Federighi, se pronunciou sobre o caso dias depois. Ele afirmou que a Apple poderia “ter sido mais clara” sobre o sistema para analisar fotos do iCloud. O executivo ainda ressaltou que o sistema é totalmente auditável, que não prejudica a privacidade dos usuários e que o recurso só vai acionar alertas caso identifique mais de 30 fotos suspeitas.

“Está bem claro que muitas mensagens ficaram confusas, e o funcionamento do sistema ficou mal entendido”, declarou. “Gostaríamos que isso tivesse ficado um pouco mais claro para todos, porque nos sentimos felizes e fortes em relação ao que estamos fazendo”.

Durante o anúncio da ferramenta, a Apple afirmou que o sistema para analisar fotos do iCloud seria implementado inicialmente nos Estados Unidos. Mas a companhia também pretende levá-lo a mais países no futuro.

Com informações: 9to5Mac