O que acontece quando bots da Wikipédia resolvem brigar entre si

Os bots exercem um papel importante no ecossistema da Wikipédia: são códigos que realizam pequenos ajustes e automatizam processos tediosos, como reverter atos de vandalismo. No entanto, mesmo tendo a melhor das intenções, eles nem sempre se comportam direito. O que acontece quando um robô briga com outro?

De acordo com um novo estudo no PLOS ONE, isso é algo que ocorre bastante. Na Wikipédia em português, bots reverteram o trabalho de outro bot em média 185 vezes ao longo de uma década, em comparação com uma média de 2,3 vezes para editores humanos.

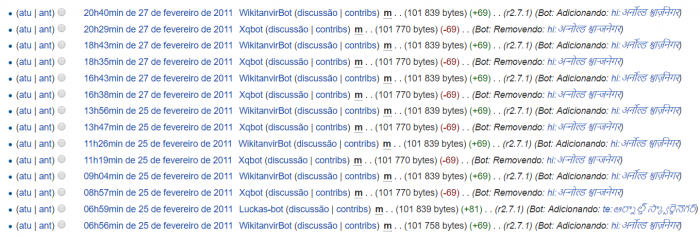

O estudo analisou a Wikipédia em treze idiomas diferentes, e cita alguns artigos em que a “briga de bots” aconteceu mais. Um deles é a página sobre o ator e político Arnold Schwarzenegger: enquanto um robô colocava o link para a versão em hindi (principal idioma da Índia), o outro insistia em retirá-lo. Assim, 69 bytes eram constantemente inseridos e eliminados, até um deles parar:

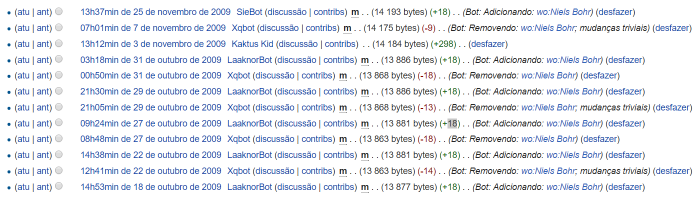

Isso também ocorreu no artigo sobre o físico Niels Bohr: enquanto o LaaknorBot inseria o link para um idioma obscuro (wolof), o Xqbot ia lá e removia. A disputa se estendeu por semanas, até um terceiro bot entrar na história e tornar as mudanças permanentes.

Além disso, a Wired menciona a briga entre dois robôs que cuidam de redirecionamento de links. Ao longo de três anos, o Scepbot reverteu 1.031 vezes as edições do RussBot; enquanto este devolveu o favor 906 vezes.

Isso acontece, claro, porque um bot é feito para realizar tarefas simples, não para decidir se uma alteração em um artigo é válida ou relevante. E, ao contrário de humanos, esses pedaços de código não se cansam de reverter edições – na verdade, isso faz parte de sua essência.

Existem cerca de oitenta bots ativos na Wikipédia em português, e quase duzentos na versão em inglês. O coautor do estudo Taha Yasseri, da Universidade de Oxford, diz à Wired que robôs realizam de 10% a 50% de todas as edições, dependendo do idioma.

Ainda assim, a Wikipédia está longe de virar um caos gerado por inteligência artificial: ela tem um processo de aprovação de bots para detectar possíveis conflitos, e seus criadores ficam de olho para detectar comportamentos anômalos.

Na Wikipédia, existem bots de análise que identificam vandalismo ou violações de direitos autorais; bots de edição para desfazer vandalismo, impor proibições, corrigir ortografia e criar links entre idiomas; e até serviços avançados como o ORES (Serviço Objetivo de Avaliação de Revisões), que usa aprendizagem de máquina para identificar se uma edição é uma mudança bem-intencionada ou se é vandalismo.

O estudo analisou dados entre 2001 – início da Wikipédia – e 2011. Esta é considerada a “primeira geração” de bots; nos anos seguintes, a Wikidata (base de dados unificada entre diversos idiomas) assumiu algumas das tarefas que antes ficavam a cargo da enciclopédia. Você pode conferir o estudo completo, em inglês, aqui.