Todas as novidades que o Google apresentou hoje (maio de 2016)

Assistente virtual, plataforma de realidade virtual, Android Wear 2.0 e muito mais

Assistente virtual, plataforma de realidade virtual, Android Wear 2.0 e muito mais

Durante o Google I/O, evento para desenvolvedores que acontece nesta quarta-feira (18), o Google apresentou novidades bem interessantes em sua diversidade de produtos. Eles sinalizaram um enorme apreço pela inteligência artificial, principalmente no anúncio do Google Assistant e no final da keynote.

Também foi anunciado o Google Home, um gadget para ficar na sua casa e responder às suas perguntas, além de dois aplicativos de mensagens, chamados Allo e Duo. Abaixo você confere a nossa cobertura completa.

Tem certeza que não quer ler esse textão cheio de informações úteis sobre o I/O? Ah, então você tem pouco tempo? Não tem problema, eu serei seu guia. Abaixo, os principais pontos do evento para leitura em menos de um minuto:

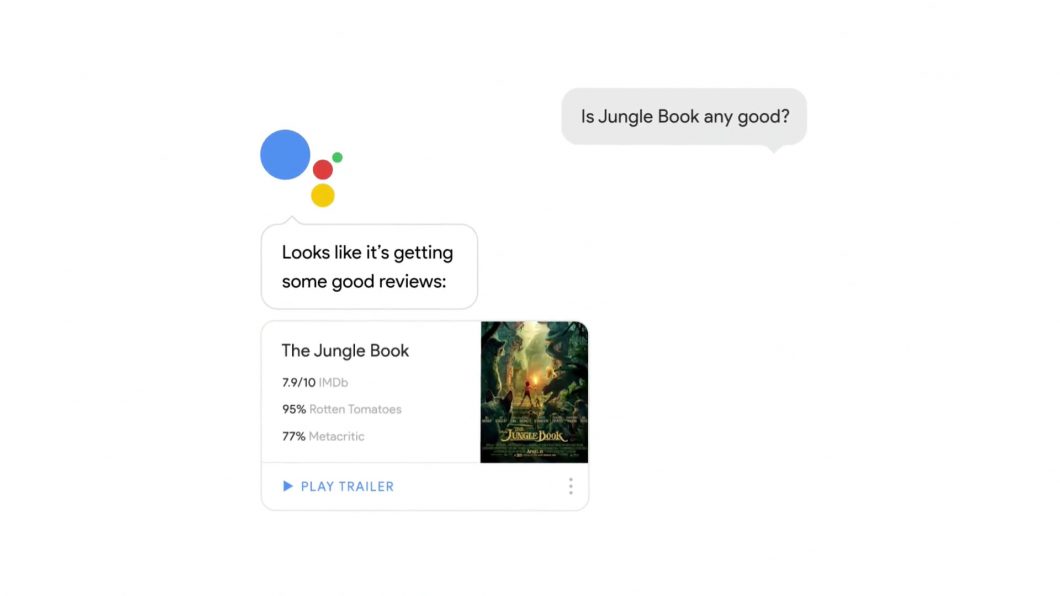

Pichai começou a apresentação falando das pesquisas — 60% agora vêm de dispositivos móveis. Ele detalha o Knowledge Graph, que mostra informações na pesquisa, não só links. Se você procura por Beyoncé, por exemplo, aparecem informações da cantora, além da opção de ouvir as músicas mais populares da artista. Toda essa incrementação foi suficiente para o Google oficializar um assistente virtual, batizado de… Google Assistant. É, aparentemente criatividade não é um dos recursos dela.

O propósito do Google Assistant é fazer exatamente o que o nome indica — um assistente que usa linguagem natural e conversas para entregar informações que o usuário precisa. É o concorrente direto da Siri e Cortana, que usa muitas das funções que o Google Now já oferecia, como a contextualização de perguntas. Se você faz uma pergunta e depois quer falar sobre algo relacionado, a assistente vai entender.

O Assistant deve substituir a pesquisa por voz em vários dispositivos móveis, como smartphones, tablets, relógios, carros, TVs e até em casa — pelo Google Home, mais um dispositivo para a sua casa fabricado pela empresa.

Mario Queiroz, vice-presidente de produtos, detalha o Home, que terá opções de customização da base para se misturar na sua casa. Dentro dessa caixa cinza, há um speaker de alta qualidade para tocar música e te informar das tarefas diárias, além de conversar com você quando você chamá-lo. Como se esperava, ele funciona como uma espécie de Chromecast Audio também.

Eu vejo o Google Home como um Chromecast com Google Assistant — ele também se conecta com outros eletrônicos da sua casa, como outros alto-falantes e TVs. Assim, dá pra você controlar o que assistir na TV falando apenas “reproduza Game of Thrones na TV”, por exemplo.

O gerenciamento de tarefas do Home não só funciona como alarme e lista de tarefas, mas também funciona como o centro da internet das coisas, como lâmpadas inteligentes, termostatos e mais. Queiroz diz que, no futuro, dará até para pedir comida por delivery.

Com a sua permissão, ele também analisará as informações que o Now já entrega, como dados de voo, rastreamento de encomendas, trânsito e outros. No vídeo de apresentação, também dá pra usar o Home como um “sabe-tudo”, em que você faz perguntas sobre espaço, estrelas e outras coisas curiosas que ele responde.

O Google Home estará disponível até o final do ano. Ele se integra com o Uber, Spotify, WhatsApp, TuneIn, Pandora e vários outros serviços, que já tinham parcerias bacanas com a empresa.

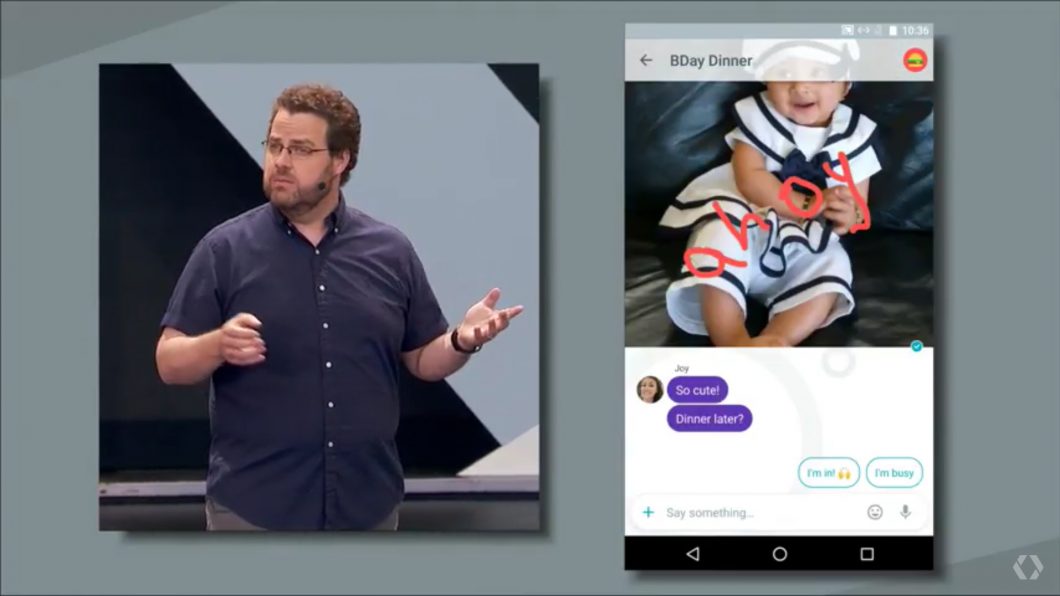

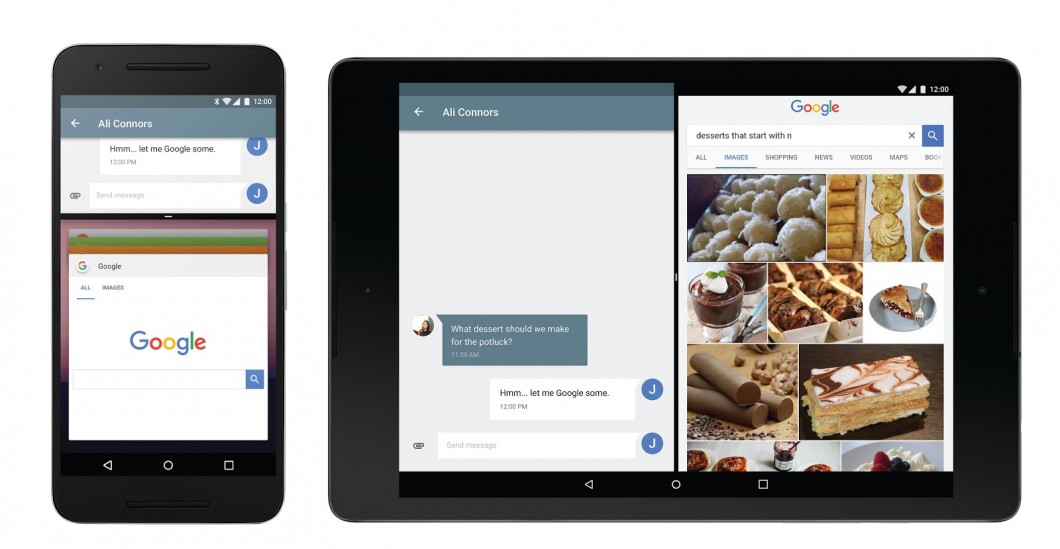

A empresa resolveu usar todas as suas tecnologistas interessantes de inteligência artificial para criar o Allo, um simples aplicativo de mensagens. Mais um?! Pois é. Mas o Allo é diferente: ele identifica as mensagens que você recebe e sugere respostas. Isso também funciona com imagens: ao receber uma foto de um cão fofinho, o Allo sugere “Awww”, “Que fofo!” e similares.

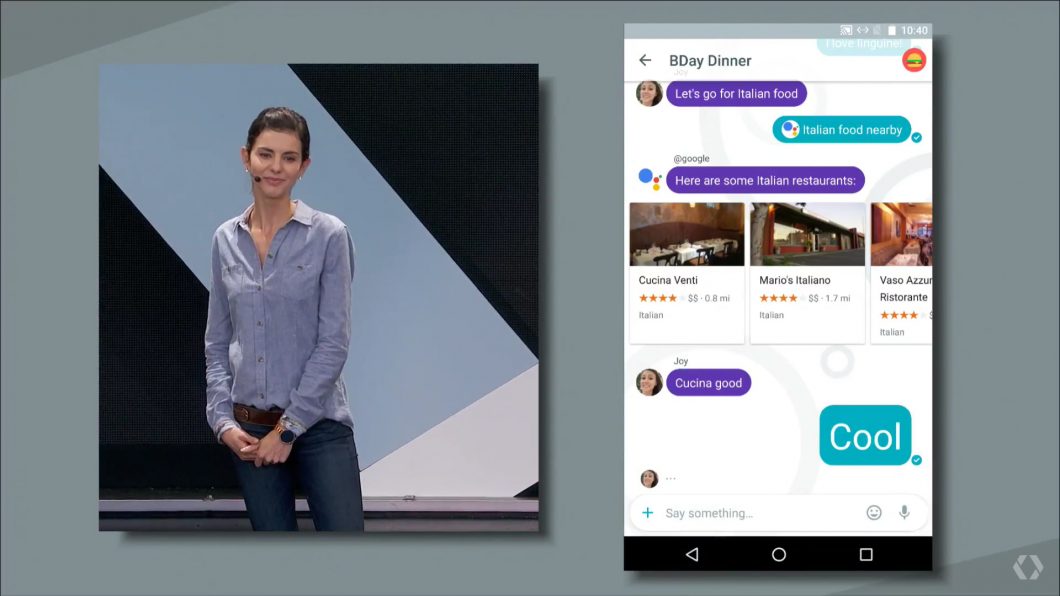

O Assistant também tem integração com o Allo, e entra para o time de chat bots que as gigantes de tech estão desenvolvendo. A Microsoft já apresentou o Bot Framework, o Facebook incluiu robôs no Messenger e até o Telegram já entrou na onda.

Esse assistente do Allo também é divertido. Você escreve “vamos jogar um jogo”, por exemplo, e ele sugere um game chamado Emoji Movies. O assistente envia emojis e você tem que adivinhar o filme. Tudo isso com um robô! Divertidíssimo.

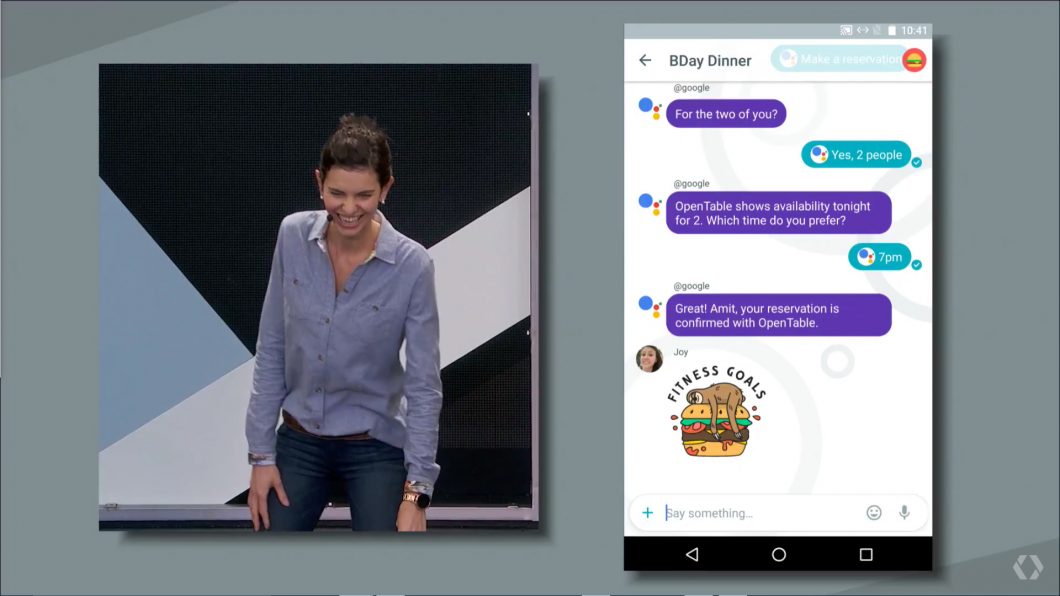

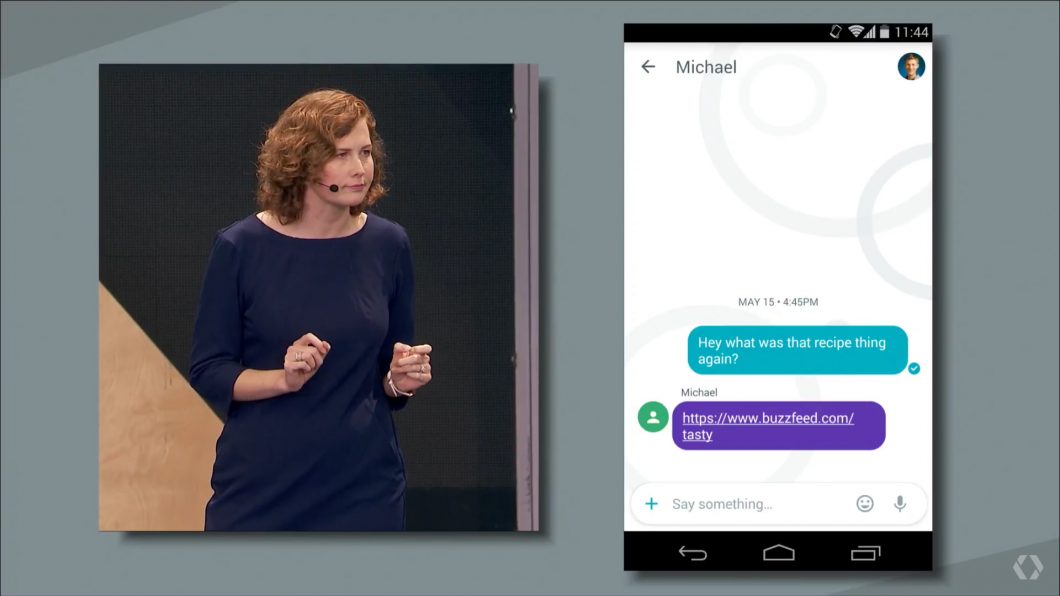

Sem contar que ele também pode ser útil de verdade algumas vezes, como participar da conversa dos seus amigos em um grupo. Você pode pedir para ele fazer uma reserva com o OpenTable, por exemplo. A imagem acima mostra como isso é possível.

Por fim, o app também tem um modo privado, em que todas as mensagens são criptografadas em E2E e as notificações que você recebe tem o conteúdo censurado. Se você deleta uma conversa, ela some para sempre, como os chats secretos do Telegram.

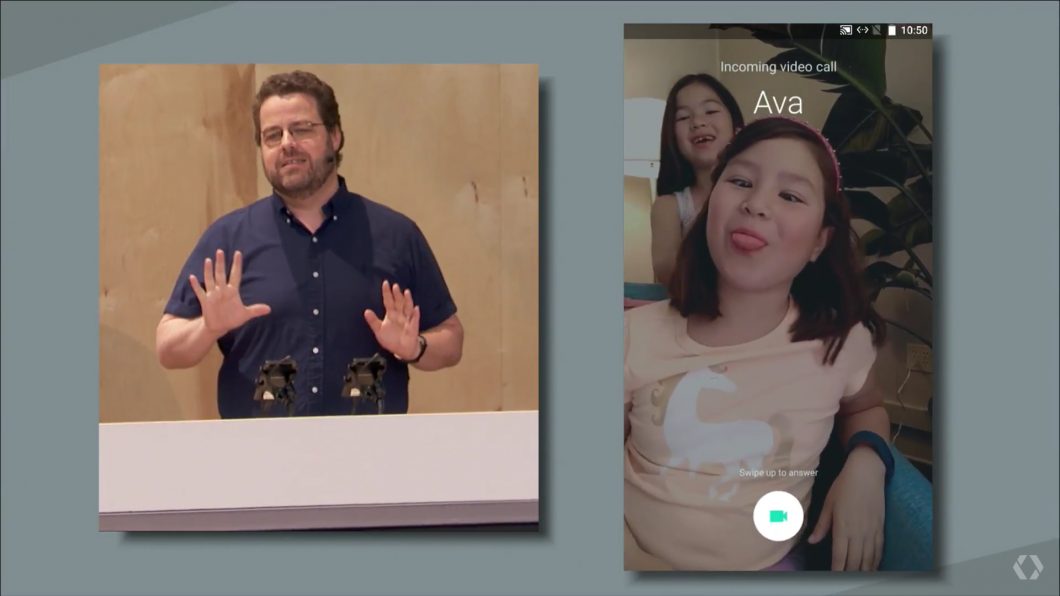

Como se não fosse o suficiente, o buscador resolveu inventar outro aplicativo, batizado de Duo, mas um que se integra com o Allo. Ele serve para vídeo-chamadas e funciona até em conexões lentas — todas são criptografadas pelo protocolo QUIC, desenvolvido pelo Google. Pessoas que participaram do desenvolvimento do WebRTC, plataforma que serve de base para a maioria das chamadas de vídeo de hoje, também colaboraram no desenvolvimento do Duo.

Além de uma vídeo-chamada de alta qualidade, o Duo também oferece uns recursos legais. Erik Kay, que estava apresentando as novidades do aplicativo, disse que o aplicativo já começa a transmitir o vídeo de quem está te ligando antes de você atender, assim você pode ver como a pessoa está. As filhas de Kay estavam com muita vontade de falar com ele no meio da apresentação — então ele resolveu atender.

Dave Burke, vice-presidente do Android no Google, foi ao palco para falar um pouco sobre a mais recente versão do Android. Parece que o buscador não teve muitas ideias para o nome, então usuários poderão dar sugestões em android.com/n.

Você já viu as novidades da prévia do N aqui. Burke detalha alguns dos principais destaques da versão, como desempenho e segurnaça. Na segurança, a criptografia do telefone agora é a nível de arquivos. Além disso, as atualizações dessa versão serão como no Chrome: há dois arquivos de software, em que um é atualizado automaticamente, sem você fazer nada. E o melhor: aquela tela de “Android está iniciando” não vai aparecer mais. Yay!

Uma novidade bem interessante é o sistema SafetyNet, que analisa os aplicativos maliciosos e desinstala-os automaticamente caso encontre uma irregularidade, sem permitir que o usuário seja danificado. A empresa diz que ele verifica 8 bilhões de apps por dia.

No desempenho, ele falou da API Vulkan, que deve melhorar o desempenho em jogos de 30 a 60% (!). Além disso, a empresa fez alguma mágica para os aplicativos serem instalados mais ráido, chamado de JIT. As instalações ficam 75% mais rápidas e os aplicativos, 50% menores.

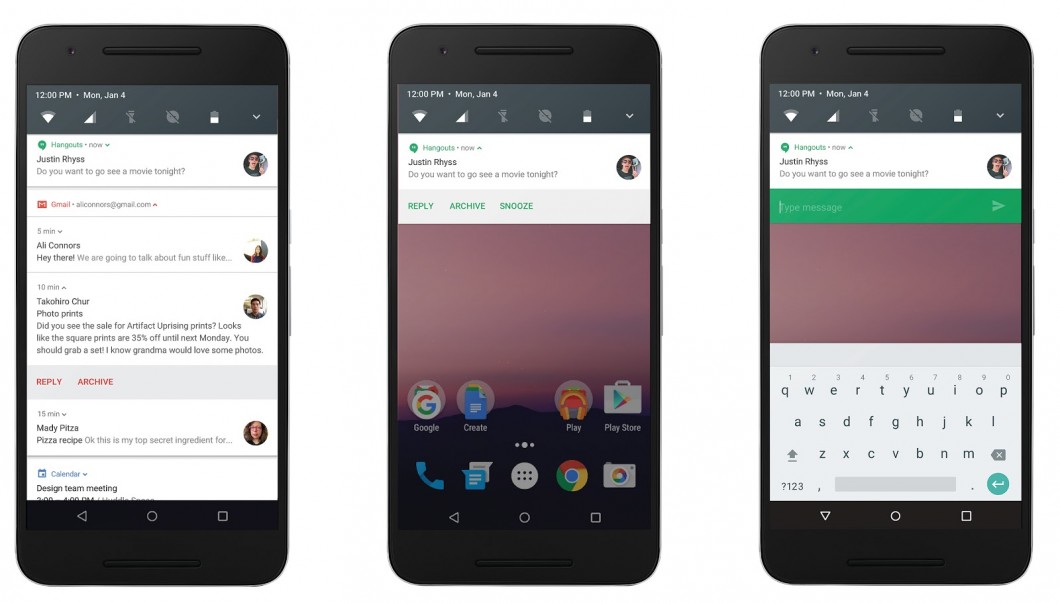

Notícia boa para quem adora fechar todos os apps no menu multi-tarefa: o N está cada vez mais inteligente — e te ajuda na produtividade, que é o terceiro ponto apresentado por Burke. O menu de multi-tarefa agora terá aplicativos que você usa pouco fechados automaticamente, assim como um botão de fechar tudo o que está aberto acima dos apps.

Outros aspectos que Burke apontou para a produtividade incluem o recurso de multi-janela nos dispositivos móveis e o de picture-in-picture (PIP) na TV. O novo sistema de notificações nos smartphones também permite que você responda mensagens direto da barra (para vários aplicativos!) sem precisar sair do aplicativo em que você está.

O Google libera nesta quarta-feira (18) o beta do Android N, que pode ser instalado no seu dispositivo principal, de acordo com Burke. É só entrar em android.com/beta.

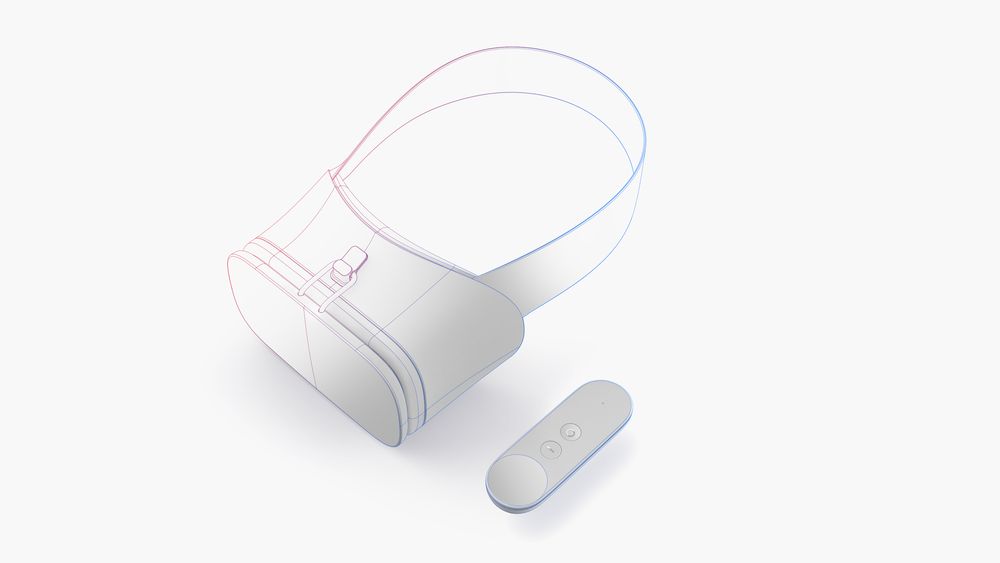

Clay Bavor, vice-presidente de realidade virtual, subiu ao palco para falar de como a empresa está investindo nessa área. Apesar do Cardboard ser uma alternativa interessante, eles queriam uma experiência mais confortável e imersiva.

Por isso, a empresa anunciou uma plataforma de realidade virtual para todos esses dispositivos móveis, batizada de Daydream. Ela faz diversas otimizações para rodar em smartphones, mas também funciona com gadgets de VR, que o Google chama de headsets. Eles criaram um modelo de headset (com um controle!) para ajudar a controlar todo esse mundo novo.

Já falamos nesta entrevista que o smartphone é um dos melhores dispositivos para exibir conteúdo em RV. No Android N, o Google criou o VR Mode, com nome autoexplicativo, para otimizar todos os sensores e componentes do smartphone para proporcionar uma boa experiência. Empresas como Samsung, LG e Asus já fizeram parceria com o Google para suportar o Daydream.

E os aplicativos? Também estão prontos. Empresas como Netflix, Wall Street Journal, The New York Times, CNN, Hulu, IMAX e USA Today já têm aplicativos com suporte a VR. Jogos da EA, Ubisoft, Climax, minorityVR e NetEase Games também. O próprio Google está adaptando seus aplicativos, como o Play Filmes, Street View, Fotos e até o YouTube — cuja plataforma de RV foi totalmente reescrita para suportar o DayDream.

Desenvolvedores interessados já podem desenvolver aplicativos para o Daydream, mas ele chega para o público final apenas até o final do ano.

Para poupar usuários de instalar aplicativos para fazer apenas uma função, o Google criou esse tal de Instant Apps para os desenvolvedores adaptarem seu trabalho para ser aberto em apenas um toque — sem a necessidade de instalação.

Funciona assim: ao fazer uma busca na internet (ou receber um link para um vídeo do BuzzFeed, como na imagem acima), o usuário precisaria abrir o app da empresa para visualizar o conteúdo. Não mais: desenvolvedores podem dividir seus aplicativos em módulos e o Google Play baixará em segundos apenas a parte que for necessária para rodar aquela ação.

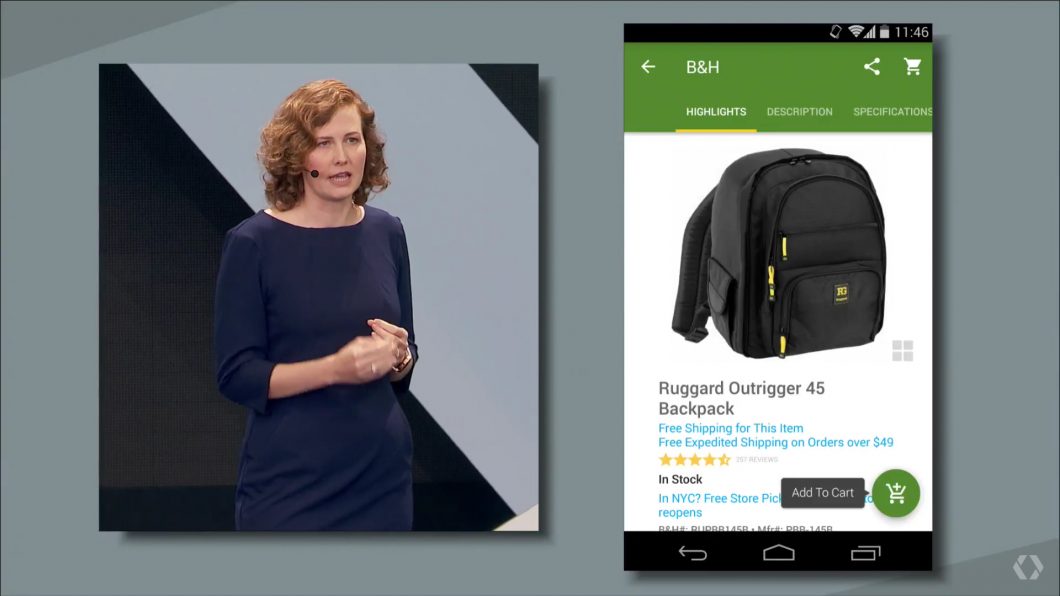

Outro exemplo interessante é a busca por uma mochila na B&H, renomada loja de fotografia norte-americana. Ao procurar pelo produto no Google e clicar no link do site, o usuário recebe apenas uma sugestão de instalar o aplicativo deles. Com o Instant Apps, o app da loja será carregado automaticamente com as informações do produto — e dá pra adicioná-lo ao carrinho e até comprá-lo, inclusive com o Android Pay. Muito bacana!

É a mesma API e o mesmo código-fonte que rodam, a diferença é que o Google vai dar a opção para os desenvolvedores dividirem os aplicativos em pequenas seções que poderão ser carregadas. Não será um trabalho difícil: segundo a empresa, em menos de um dia eles podem adaptarem seu trabalho. E o melhor: não é exclusivo do Android N; pelo contrário, funciona até no Android 4.1 Jelly Bean (!) ou superior.

Mas não comemore tão cedo: apesar dos desenvolvedores poderem testar essa funcionalidade logo, o Google quer uma certa calma para supervisionar como cada app vai ser adaptado. Por isso, espere esse recurso funcionando só daqui a alguns meses.

Finalmente! A plataforma Android Wear foi atualizada para a versão 2.0 — depois de dois anos (!) da primeira versão final. As faces de relógio agora podem mostrar mais informações — de qualquer aplicativo — que o usuário considera útil.

Recursos como o Smart Reply, do Inbox e do Allo, também estarão disponíveis nessa segunda versão. Para melhorar a digitação, o Google também incluiu um teclado (!) e um modo de caligrafia para você escrever à mão.

Outro ponto interessante é que os aplicativos feitos para o Android Wear 2.0 não dependem mais do seu smartphone. De acordo com os sensores do seu relógio, o aplicativo pode se conectar à internet por Wi-Fi ou Bluetooth e entregar informações sem depender de outro dispositivo.

Assim, a experiência de sair para correr, por exemplo, fica bem melhor. Toda a API do Google Fit, app de atividades do Google, agora está embutida na segunda versão do sistema. Isso inclui o reconhecimento de atividades e a troca de dados entre aplicativos desse tipo, para sincronizar todos os seus exercícios. Até dá pra fazer streaming do Spotify sem levar o smartphone para a corrida!

Desenvolvedores já podem acessar a prévia dessa segunda versão em g.co/wearpreview.

Pichai terminou a conferência falando dos avanços que o Google já fez na inteligência artificial. Tanto a abertura da APIs de bibliotecas de aprendizagem de máquina, como TensorFlow, o que incentiva desenvolvedores, quanto em sistemas que eles mesmos constroem. O presidente do Google sinaliza que a empresa vai continuar abrindo espaço para desenvolvedores mexerem com essas ferramentas.

Uma curiosidade interessante sobre o jogo do AlphaGo contra o campeão mundial Lee Sedol, cuja importância já foi ressaltada neste post, é que um movimento usado — especificamente, o número 32 no segundo jogo — serviu de referência para a comunidade Go, considerando-o como muito criativo e inovador. É até engraçado dizer que foi um robô que usou a criatividade.

Outra demonstração foi a coordenação que braços robóticos estão adquirindo para pegar objetos. O Google treinou-os com aprendizagem profunda para eles irem “aprendendo” a pegar as coisas, como sabendo que afastar um objeto de outro ajuda-o a ficar mais acessível, por exemplo.

Por fim, um exemplo muito bacana na saúde: Pichai demonstrou que a IA está sendo usada, ainda que precocemente, para diagnosticar a retinopatia diabética, uma doença que pode até causar perda total da visão. É muito difícil para médicos diagnosticarem de prontidão a patologia, uma vez que requer um oftalmologista especialista em retina.

Mas, a partir de padrões detectados em tomografias oculares, máquinas podem ser treinadas para ajudar no diagnóstico. Esse teste ainda está muito precoce, mas já é um avanço muito interessante. Quem sabe no futuro teremos robôs que corroboram com diagnósticos médicos? Seria uma evolução excelente da IA.