Por que reconhecimento facial de emoções não é uma boa ideia

Softwares de IA para reconhecimento facial de emoções vêm sendo cada vez mais usados, mas princípio não é confiável e reproduz vieses

Ronaldo Gogoni 3 anos atrás

Softwares de reconhecimento facial são comuns hoje em dia, e atrelada à identificação de pessoas pelo rosto, IAs já vem sendo usadas a algum tempo para reconhecer emoções. Técnicas são empregadas para diversos fins, desde descobrir se um espectador está gostando de um filme, a identificar potenciais suspeitos em espaços públicos. No entanto, elas possuem alguns problemas conceituais que as tornam menos que confiáveis.

- Estudo aponta que máscaras quebram algoritmos de reconhecimento facial

- Era inevitável: deepfake usado como ferramenta de bullying

Tecnologias de Reconhecimento Emocional, ou ERTs na sigla em inglês, usam IA e redes neurais para ler as expressões de um indivíduo, tentando identificar seu atual estado mental. A ideia é que câmeras e sistemas possam reconhecer se uma pessoa está feliz, nervosa, apreensiva e etc, de forma a ativar respostas adequadas em diversos cenários.

Por exemplo, um sistema de ERT instalado em transportes públicos poderia identificar se os passageiros estão ou não apreciando a programação exibida nas telas embutidas em coletivos, e ajustar as atrações conforme o humor das pessoas. Por outro lado, empresas e startups usam a tecnologia em aplicações controversas, como controle de fluxo em aeroportos e no policiamento (cuidado, PDF), para identificar potenciais suspeitos, e em entrevistas de emprego, para saber quando um candidato está mentindo ou nervoso.

ERTs também são usados em softwares educacionais, para identificar se uma criança está focada enquanto estuda, e há movimentos para incluir a tecnologia no controle de fronteira dos Estados Unidos.

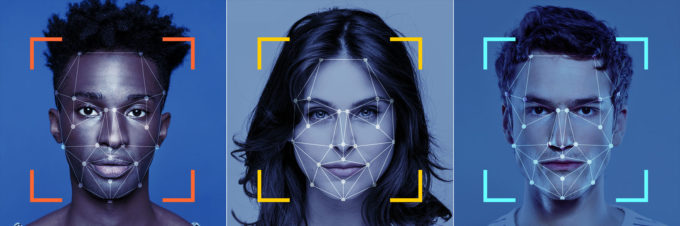

Sistemas de reconhecimento facial são tão precisos quanto quem os programou, e nesse ponto, não são raros os casos de vieses e preconceitos reproduzidos nos sistemas. Casos recentes não faltam, como o da United Health, empresa que no Brasil administra a rede Amil, que priorizava pacientes brancos em detrimento de negros, por usar uma base de dados contaminada. Softwares de identificação de suspeitos também já levaram a prisões indevidas ao replicar preconceito racial, e no Reino Unido, outro algoritmo dava notas piores a estudantes que viviam em condições sócio financeiras inferiores aos mais bem avaliados.

Recentemente, o documentário da Netflix Coded Bias (2020) trouxe à tona uma investigação conduzida pela pesquisadora do MIT Media Labs Joy Buolamwini, que identificou reprodução de preconceitos em softwares de reconhecimento facial, que não conseguia identificar faces de mulheres ou negros, por ter uma base de dados majoritariamente formada por rostos de homens brancos.

Se a identificação de rostos já reproduz vieses de quem as desenvolveu, o mesmo se aplica à identificação de emoções. Em 2018, os softwares Face++ e da API Face da Microsoft avaliou emocionalmente de forma mais negativa, conferindo menos pontos, fotos de atletas negros da NBA em detrimento de brancos. O primeiro considerou os negros mais agressivos, enquanto o segundo julgou que as expressões mostravam desprezo, mesmo se estivessem sorrindo.

Como se viés já não fosse um problema, ERTs são sistemas de reconhecimento facial apoiados em uma base não confiável desde o início, o da Teoria das Emoções Básicas. De acordo com a proposta, o ser humano possui 17 emoções primordiais (estudos recentes apontam em torno de 27), todas programadas de forma imutável e ligadas às expressões, de forma que uma pessoa sempre vai fazer uma cara específica para demonstrar medo, raiva, desprezo, alegria e etc, de forma inconsciente.

Estudos mais recentes, no entanto, não encontraram relação entre sentimentos e expressões faciais, e as mesmas costumam ser diferentes dependendo do meio, variando entre culturas e sociedades. Dessa forma, não há uma forma concreta de prever como uma pessoa se sente apenas olhando para a cara dela, pois ela pode não ter uma expressão ligada ao sentimento pelo qual está passando no momento. Some-se a isso vieses diversos e temos uma IA viciada.

Baseando-se nessa série de problemas, um relatório publicado em dezembro de 2019 pelo AI Group, um centro de pesquisa da Universidade de Nova Iorque, concluiu que ERTs devem ser totalmente proibidos pelos reguladores (cuidado, PDF), afirmando que a técnica em si é suspeita por design, de modo que permite a empresas que empreguem a técnica identificarem o que quiserem, e não a realidade.

A simples ideia de um software de reconhecimento de emoções sendo usado em vias públicas para identificar possíveis suspeitos parece coisa de Ficção Científica, mas já vem sendo usada na China de forma ampla e testada nos Estados Unidos e Reino Unido. Em outras aplicações, como contratações ou plataformas de ensino os ERTs são mais comumente empregados, visto que reguladores não têm feito muito para controlar o setor.

O mais provável de acontecer é que a técnica dos ERTs continuará sendo usada até o momento em que apresentar problemas sérios de identificação, levando a prejudicar grandes empresas, mas do lado do indivíduo, pouca coisa deverá mudar.

Fonte: The Conversation