No ano passado, o Facebook ampliou seus esforços para identificar e remover conteúdo que promove discurso de ódio, incluindo racismo, xenofobia e apologia ao nazismo.

A rede social renovou o treinamento de seus moderadores de conteúdo após a marcha de Charlottesville (EUA), que atraiu centenas de neonazistas. É o que descobriu o Motherboard após obter documentos internos do Facebook.

“Incidentes recentes nos EUA (por exemplo, Charlottesville) mostraram que potencialmente há confusão sobre nossas políticas para organizações que promovem discurso de ódio”, diz um documento para moderadores criado pouco depois do protesto.

Desde então, o treinamento foi atualizado para incluir novos exemplos de incitação ao ódio. Isso inclui comparar mexicanos a criaturas semelhantes a vermes; chamar muçulmanos de porcos; e usar “it” (pronome usado para objetos e animais) para pessoas transgênero.

O Facebook faz distinções entre supremacistas brancos, nacionalistas e separatistas. A rede social não permite “elogios, apoio nem representação” da supremacia branca como ideologia. Ou seja, termos como “participe da próxima marcha da supremacia branca” seriam removidos.

No entanto, os moderadores são instruídos a não apagar posts como “o nacionalismo branco é o único caminho”, ou “os EUA deveriam ser um país apenas para brancos”.

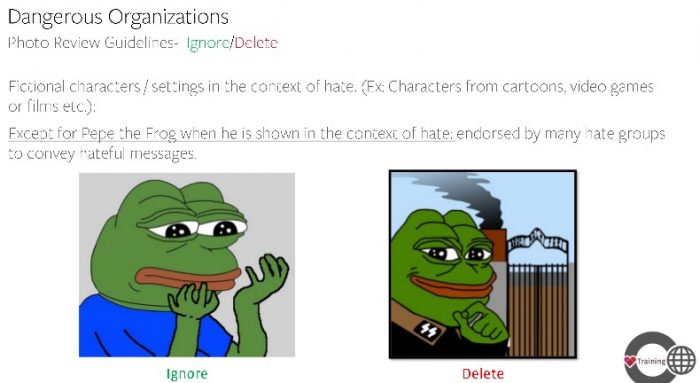

Há também uma regra específica para o Pepe The Frog, um meme que “foi endossado por muitos grupos para transmitir mensagens de ódio”, segundo o Facebook. Ao longo dos anos, o desenho de um sapo se transformou em um símbolo antissemita.

O material de treinamento fornece dois exemplos: o primeiro tem uma imagem padrão do Pepe; o segundo mostra o sapo vestido com um uniforme da SS — organização paramilitar ligada a Adolf Hitler — em frente a um campo de concentração. No caso, o moderador deveria remover apenas a segunda imagem.

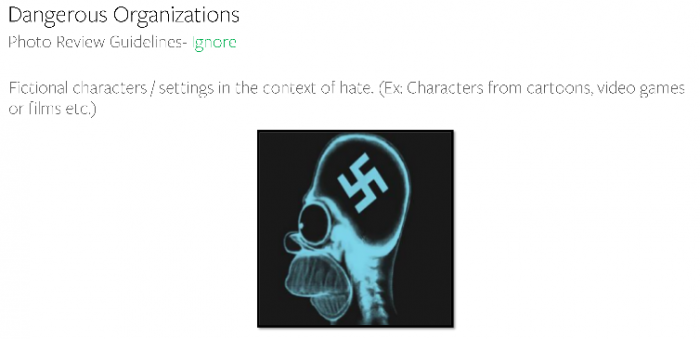

No entanto, o Facebook libera qualquer outro personagem de desenho animado ou videogame, mesmo para discurso de ódio. O material inclui um exemplo de Homer Simpson com uma suástica na cabeça; um post como esse não seria removido.

O Facebook classifica grupos de ódio e indivíduos com base em sinais fortes, médios e fracos. Um sinal forte é participar de organizações como a Ku Klux Klan (KKK), United Klans of America ou Aryan Nations. Um sinal médio é usar o nome ou símbolo de um grupo organizado. E um sinal fraco é participar de marchas em que há grupos de ódio presentes — como foi o caso de Charlottesville.

“Nossas políticas contra grupos de ódio organizados são duradouras e explícitas — não permitimos que esses grupos mantenham uma presença no Facebook porque não queremos ser uma plataforma para o ódio. Usando uma combinação de tecnologia e pessoas, trabalhamos agressivamente para erradicar conteúdo extremista da nossa plataforma”, diz o Facebook em comunicado.

No primeiro trimestre de 2018, o Facebook eliminou 2,5 milhões de posts contendo discurso de ódio. A filtragem é feita com auxílio de inteligência artificial, mas apenas 38% desse total foram removidos de forma automática.

Com informações: Motherboard, (2).