Google vai usar inteligência artificial para deixar busca mais atraente

Empresa aposta em recursos visuais e conteúdos criados pela comunidade; jovens e adolescentes passaram a usar Instagram e TikTok como ferramentas de busca

Empresa aposta em recursos visuais e conteúdos criados pela comunidade; jovens e adolescentes passaram a usar Instagram e TikTok como ferramentas de busca

O Google vai tornar sua busca menos dependente de palavras-chave e mais baseada em imagens e perguntas. Nesta quarta-feira (28), a empresa mostrou, em seu evento anual Search On, algumas das ferramentas que estarão disponíveis. Elas devem chegar em breve, tanto ao buscador quanto a apps como o Google Lens e o Google Maps.

Executivos do Google ouvidos pelo site The Verge dizem que a internet mudou muito nas últimas décadas, e a busca não pode mais depender de o usuário digitar os termos corretos.

Na verdade, isso é cada vez menos necessário, com os avanços na inteligência artificial, que permitem processar de maneira mais precisa e articulada a linguagem usada nas perguntas.

O Google também está vendo o surgimento de alguns concorrentes improváveis. Uma parcela dos jovens e adolescentes diz fazer buscas no Instagram e no TikTok. Geralmente, as redes são fontes mais interessantes para assuntos como culinária, moda e dicas, em que as melhores respostas costumam vir de outros usuários.

Uma das novidades é a chamada Multisearch. Com ela, dá para usar imagens e palavras em uma mesma busca.

O Google deu dois exemplos: tirar uma foto de uma camisa e digitar “gravata” para encontrar gravatas com aquela estampa, e escolher a imagem de um vestido verde e digitar “roxo” para encontrá-lo naquela cor.

A empresa diz que isso funciona “da mesma forma com que a gente aponta para alguma coisa quando quer fazer uma pergunta sobre o que está vendo”.

O Multisearch já está disponível em inglês e deve chegar ao Brasil, em português, nos próximos meses. Mais de 70 idiomas terão acesso ao recurso.

Outra forma de usar o Multisearch é escolher uma imagem, ou tirar uma foto, e logo em seguida digitar o termo “perto de mim”. O Google, então, mostra onde encontrar aquele prato ou produto na região onde você está.

Essa função ainda não está disponível; ela deve chegar aos EUA ainda este ano.

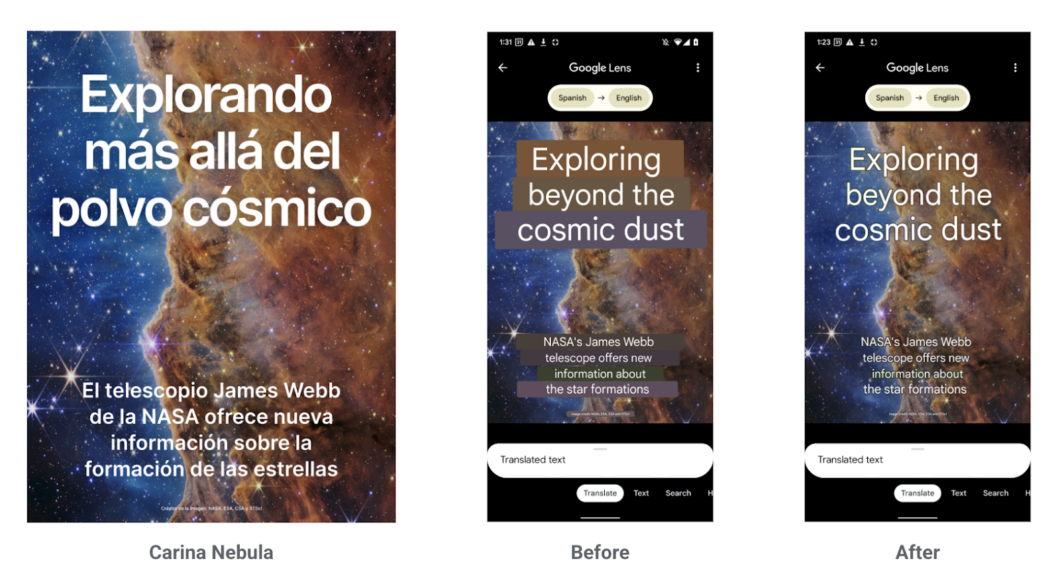

Um dos recursos mais interessantes do Google Lens é traduzir textos capturados pela câmera. A ferramenta entrega o que promete e você consegue entender o que está escrito, mas o resultado nem sempre é muito bonito, já que o app borra a imagem de fundo.

A partir de agora, o aplicativo vai apagar o texto original usando inteligência artificial e sobrepor a tradução à imagem, como se ela já tivesse sido feita com aquele texto.

Mesmo com tantas novidades, tem quem prefira fazer a busca digitando. Agora, o Google vai sugerir perguntas que podem ser interessantes para o termo que está sendo escrito.

No exemplo compartilhado pela empresa, ao digitar “México”, o buscador pode sugerir “melhores cidades no México para famílias”.

Ao selecionar uma cidade, será possível ver vídeos curtos postados dos por outros usuários, além de informações relevantes como transporte e atividades.

Os recursos ainda vão ser lançados nos EUA, em inglês, nos próximos meses.

O Google Maps também vai mostrar a “vibe” de um determinado bairro ou região com informações geradas pela comunidade, como fotos, dicas e recomendações. O aplicativo ganhará essa opção nos próximos meses, tanto no Android quanto no iOS.

Essas ferramentas parecem ser uma resposta à já mencionada preferência dos mais jovens pelo Instagram e pelo TikTok.

Quem recorre a essas redes não quer uma informação precisa, mas, sim, explorar as sugestões existentes, descobrir coisas legais e saber o que outros usuários recomendam.

Com essas opções, o Google quer ajudar esses usuários — e recuperar essa pequena parcela do público que hoje usa plataformas de mídia social para fazer buscas.

Com informações: Google, The Verge.