StableLM é um concorrente de código aberto para o ChatGPT

Feito pela mesma empresa que criou o gerador de imagens Stable Diffusion, modelo de linguagem promete resultados similares ao do GPT-3 com mais eficiência

Feito pela mesma empresa que criou o gerador de imagens Stable Diffusion, modelo de linguagem promete resultados similares ao do GPT-3 com mais eficiência

A Stability AI ficou famosa nos últimos meses com o Stable Diffusion, modelo de geração de imagens com inteligência artificial. Agora, ela vai partir para o campo da escrita. A empresa anunciou uma alternativa ao ChatGPT chamada StableLM, com código aberto.

O StableLM gera texto prevendo qual o próximo token, como é chamado o fragmento de palavra. A sequência começa com uma informação fornecida por um ser humano.

O funcionamento é bem parecido com o GPT-4, modelo grande de linguagem (LLM, na sigla em inglês) que serve de base para o ChatGPT.

“Modelos de linguagem formarão a espinha dorsal da nossa economia digital, e queremos que todo mundo possa opinar nesses projetos”, diz a Stability AI no blog post anunciando a novidade. “Modelos como o StableLM demonstram nosso compromisso com tecnologias de inteligência artificial transparentes, acessíveis e solidárias.”

Por enquanto, o StableLM está em fase alpha. Ele foi disponibilizado no GitHub, nos tamanhos de 3 bilhões e 7 bilhões de parâmetros. A Stability AI promete que os modelos de 15 bilhões e 65 bilhões de parâmetros serão liberados em breve.

Os parâmetros são variáveis que um modelo usa para aprender a partir dos dados de treinamento. Números menores significam que os modelos podem ser mais eficientes, podendo rodar localmente em notebooks ou smartphones.

Por outro lado, eles precisam de projetos mais elaborados para conseguir entregar bons resultados usando menos recursos.

O StableLM é mais um dos modelos grandes de linguagem a prometer desempenho próximo ao do GPT-3, da OpenAI, com número menor de parâmetros — o GPT-3 usa 175 bilhões.

Outros são o LLaMA, da Meta; o Alpaca, de Stanford; o Dolly 2.0; e o Cerebras-GPT.

Os modelos foram disponibilizados sob a licença Creative Commons BY-SA-4.0. Isso significa que projetos derivados devem dar créditos ao autor original e ser compartilhados usando a mesma licença.

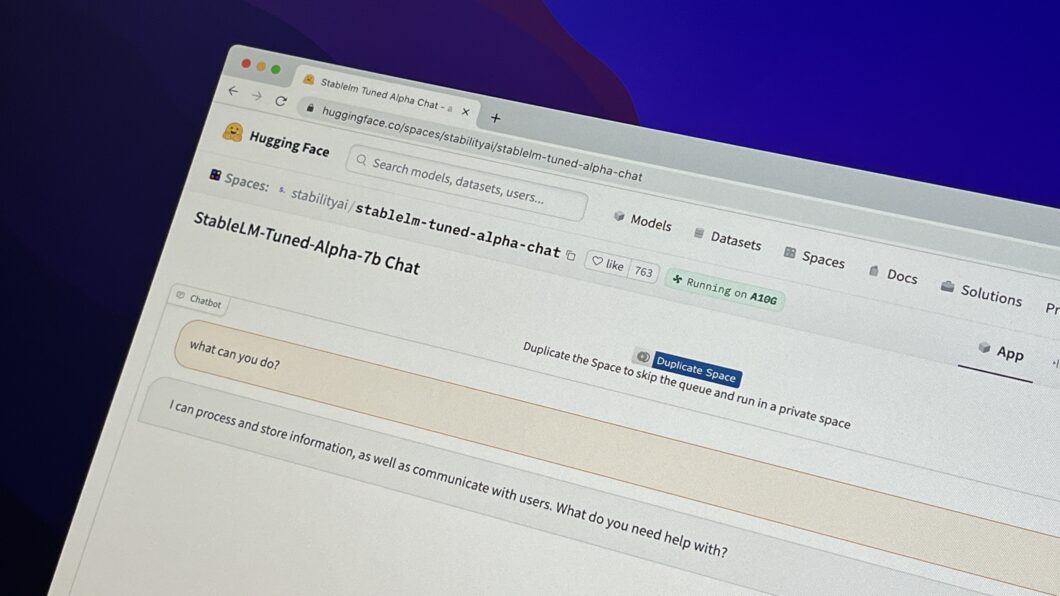

Por enquanto, é possível testar uma versão do modelo de 7 bilhões de parâmetros já customizada para chatbots no Hugging Face.

Com informações: Stability AI, Ars Technica