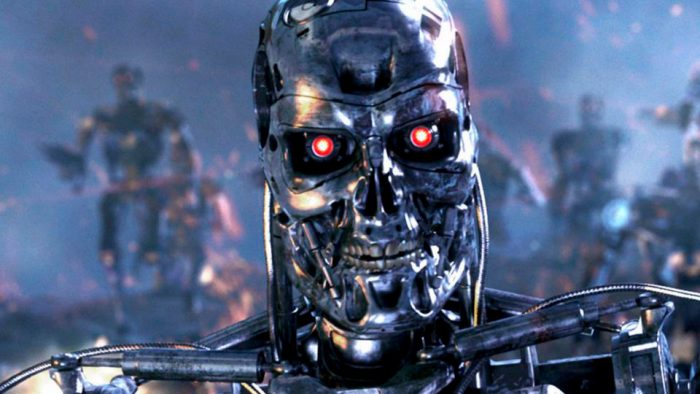

Quem estudou o dilema do prisioneiro já sabe: na escolha por cooperar ou dedurar o amiguinho, o resultado final pode ser bem egoísta se o benefício próprio for melhor que o coletivo. Esse problema também permeia a inteligência artificial, que em um futuro distópico pode acabar com a humanidade. Em testes, o Google não vem nos dando notícias muito boas.

Em um artigo publicado por pesquisadores da DeepMind, divisão de IA do Google, os pesquisadores testaram em dois jogos as probabilidades de cooperação entre dois agentes de IA. Os resultados mostram que, até a situação ficar dentro do controle, um agente prefere cooperar. Depois, a derrota do inimigo é preferível, caso a cooperação não tenha maiores benefícios.

O primeiro jogo, chamado de Gathering, colocava os dois jogadores frente a frente para coletar o maior número de maçãs possível. Conforme o número de frutas ia diminuindo, os agentes ficaram agressivos e começavam a atacar um ao outro com raios de laser, que paralisavam o outro jogador por alguns segundos.

Teoricamente, se ambos cooperassem, poderiam acabar com a mesma quantidade de maçãs ― tática que algoritmos menos desenvolvidos da DeepMind usaram. Mas, com o resultado incerto, os agentes “mais desenvolvidos” preferiram se atacar para assegurar o melhor resultado. O vídeo abaixo mostra a partida acelerada. Os blocos azul e vermelho são os jogadores e os quadrados verdes são as maçãs.

Para chegar ao resultado divulgado, foram mais de 40 milhões de partidas. Os pesquisadores perceberam que, quanto mais o agente aprendia com os jogos, mais táticas agressivas eram usadas para alcançar a vitória, aprendendo com os erros e acertos dentro do seu próprio ambiente.

Em outro jogo, chamado de Wolfpack, os resultados foram menos assustadores. Neste, dois lobos precisavam se unir para capturar uma presa. Em vez de correrem para ver quem chegava primeiro, ambos cooperaram para encurralar a presa. Isso porque a cooperação, nesse cenário, era recompensada com mais pontos: não importa qual lobo pegasse a presa, se o outro também estivesse próximo, ele receberia pontos da mesma forma. Veja o teste no vídeo abaixo:

É interessante (e assustador!) ver como, nestes testes, a IA consegue discernir entre situações em que a agressão e o egoísmo trazem mais vantagens, enquanto em outros cenários, a cooperação é preferível. No blog da DeepMind, o autor do experimento explica que ele serve para entender melhor sistemas complexos de vários participantes, como economia, trânsito e meio-ambiente, “todos que dependem da nossa cooperação contínua”.

Com informações: Science Alert.

![Tem como mudar o e-mail do Google? [Gmail, Play Store, YouTube]](https://files.tecnoblog.net/wp-content/uploads/2021/02/como-mudar-o-e-mail-do-google-340x191.jpg)

![O que é Smart Lock no Android [e como isso funciona]](https://files.tecnoblog.net/wp-content/uploads/2018/09/phone-1537387_1280-340x191.png)