Plataforma usa GPT-3 para dar consultoria de saúde mental sem avisar participantes

Aplicativo Koko causou polêmica ao usar IA base do ChatGPT para consultoria de saúde mental sem consentimento; CEO tentou se justificar e só foi piorando a história

Aplicativo Koko causou polêmica ao usar IA base do ChatGPT para consultoria de saúde mental sem consentimento; CEO tentou se justificar e só foi piorando a história

O Koko, app para pessoas buscarem ou darem apoio emocional, testou o uso de uma inteligência artificial com 4.000 participantes sem informá-los de que se tratava de uma “máquina”. A revelação da “pesquisa” foi divulgada por Rob Morris, cofundador da empresa no Twitter, em uma thread que ele aparentava estar muito contente com o teste. O caso, um exemplo de antiética em pesquisas, foi altamente criticado — e com razão.

De acordo com Morris, 30.000 mensagens foram usadas com o GPT-3, tecnologia base do ChatGPT, e uma equipe de humanos foi usada como “co-pilotos” da IA. Ainda assim, mesmo com “co-pilotos”, o teste viola exigências do Departamento de Saúde dos Estados Unidos. Mesmo feliz com os resultados, Morris era obrigado a informar os participantes do teste.

Rob Morris, que também passou pelo Airbnb, recebeu uma enxurrada de críticas na thread em que divulgou o teste no Koko. Lembrando: o Koko é uma plataforma na qual pessoas que precisam de um “ombro amigo” vão em busca de apoio de usuários humanos, buscando um contato mais pessoal e empático.

Além de várias mensagens apontando como a prática de testar algo sem consentimento é antiético, estava o relato de pessoas que trabalharam com pesquisas na área de saúde. Em uma das respostas, um usuário divulgou a página do Departamento de Saúde dos Estados Unidos na qual está o FAQ sobre consentimento em pesquisas relacionadas a saúde.

Em sua defesa, o cofundador do app explicou que os testes eram internos e não serão divulgados. O médico aposentado Daniel Shoskes, que afirma ter participado de comitês de avaliação de pesquisas, respondeu a Morris destacando que ele estava utilizando um grupo vulnerável para uma pesquisa e sem informá-los de que eles participariam de um teste — seja com objetivo de publicá-lo ou não.

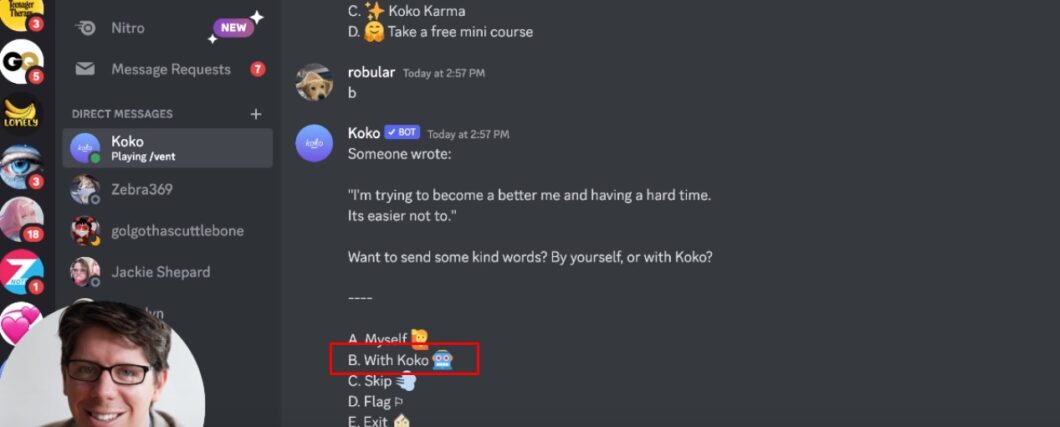

Em um vídeo publicado no Loom, Morris explica o funcionamento da IA. Um voluntário, ao receber uma mensagem de uma pessoa pedindo algum apoio emocional, tem a opção de escolher que a IA gere a resposta (ver a parte destacada na imagem acima). Ele tem a opção de seguir com a mensagem gerada ou escrever uma própria.

Segundo Morris, as respostas geradas por IA foram mais bem avaliadas do que as geradas por pessoas. Contudo, inteligências artificiais, ainda mais com a tecnologia relativamente nova do GPT-3, podem formar textos totalmente imprecisos — e com o agravo de você está lidando com um público pedindo ajuda para lidar com questões de saúde mental.

Rob Morris descobriu também algo óbvio: as pessoas perderam o interesse pelas respostas ao descobrirem que se tratava de uma mensagem criada com auxílio de uma máquina

Essa descoberta é previsível por alguns motivos. Primeiro, quem vai ao Koko acredita na proposta do app de que terá uma resposta formulada por um humano, pensando que terá mesmo uma pessoa criando empatia com a sua situação — um robô escrevendo “eu entendo” não é empático.

Segundo, seres humanos ainda são animais sociais e o contato com outra pessoa é fundamental para o bem-estar — claro, há pessoas que são a causa do nosso mal-estar. Em uma situação de vulnerabilidade, um apoio real é melhor que um apoio de uma IA que formulou a resposta com base em várias publicações encontradas na internet.

Depois da repercussão negativa, Rob Morris informou que ele se expressou de maneira equivocada e as pessoas sabiam da funcionalidade. Entretanto, na primeira thread sobre o assunto, no tweet mostrado anteriormente, ele escreveu o seguinte:

“Uma vez que as pessoas descobriram que as mensagens foram cocriadas com uma máquina, não funcionou”

O uso do advérbio “once” se traduz, em maneira literal, para “uma vez”. Ele traz, na frase, um sentido de que o uso da IA foi omitido por um tempo. O que dá a entender que talvez as pessoas sabiam da funcionalidade, mas não que estariam participando dos testes sem consentimento.

Com informações: Ars Technica e Vice