Autopilot da Tesla ‘é inocentado’ por morte em acidente de carro

Caso de 2019 vitimou motorista e feriu dois passageiros, incluindo uma criança de 8 anos; defesa das vítimas alegava falha no Autopilot

Caso de 2019 vitimou motorista e feriu dois passageiros, incluindo uma criança de 8 anos; defesa das vítimas alegava falha no Autopilot

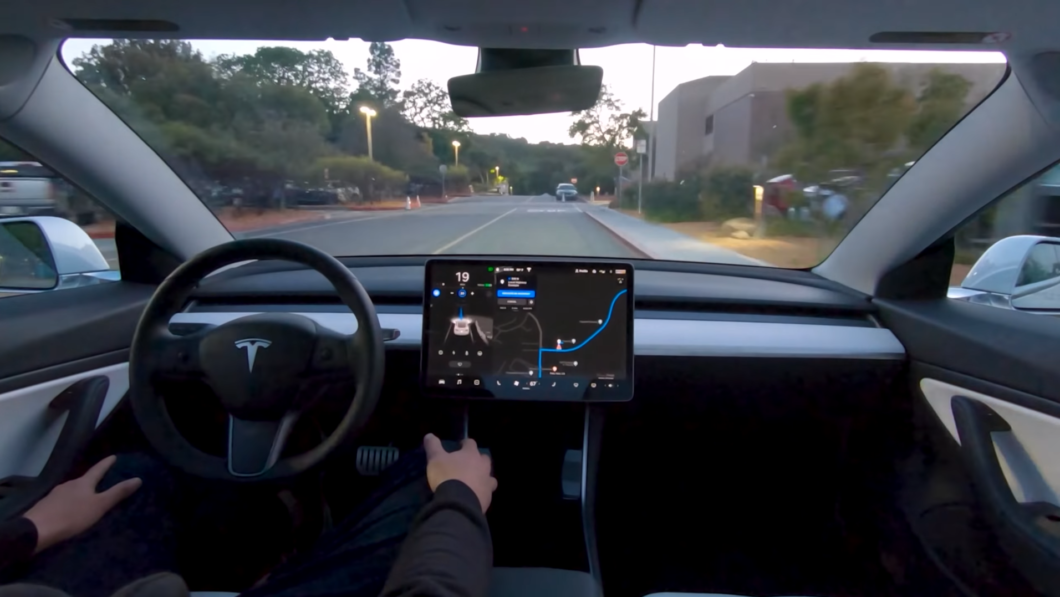

A Tesla foi inocentada de um acidente fatal ocorrido em 2019, que vitimou o motorista Micah Lee (37) e deixou dois passageiros feridos, incluindo uma criança de 8 anos. O caso foi julgado no tribunal do júri e os advogados das vítimas alegaram que a empresa vendeu o veículo sabendo que havia falhas no Full Self-Driving (FSD), recurso de direção autônoma que estava (e ainda está) na fase beta.

No acidente ocorrido em Los Angeles, o Tesla Model 3, sedã de entrada e modelo mais vendido da marca, virou abruptamente saindo da pista e se chocou contra uma árvore. No momento que saiu da pista, o veículo estava a 105 km/h. Com a batida, o carro pegou fogo e o motorista morreu no local.

Em sua defesa, a Tesla alegou que não há nenhuma garantia que o Autopilot estava ativado no momento da batida. No julgamento, a empresa alegou que houve erro humano de Micah Lee na condução do veículo, já que exames mostraram que a vítima ingeriu bebida alcoólica antes de entrar no carro.

A informação de não haver garantia se o Autopilot estar ligado levanta um ponto para a futura regulamentação da tecnologia de direção autônoma (que corre mais lenta que um Ford Ka 1.0 ano 2000). Se nem a fabricante sabe dizer se o recurso foi ativado, será que o próximo passo da tecnologia é adotar uma caixa preta igual a de aviões?

Por se tratar de um caso envolvendo mortes, o caso foi julgado no tribunal do júri. Os jurados consideraram a Tesla inocente. As vítimas e parentes de Lee exigiam uma indenização de US$ 400 milhões mais pagamento de danos.

A defesa das vítimas alegou que a Tesla conscientemente engana os consumidores ao vender o Autopilot como um serviço de direção autônoma. A fabricante saiu livre desse caso (o primeiro envolvendo uma fatalidade), mas tem outras disputas à frente.

A Tesla enfrenta vários processos envolvendo acidentes com o Autopilot ativado, com alguns sendo julgados nos próximos meses. A NHTSA, órgão rodoviário dos Estados Unidos, publicou um relatório mostrando que houve 273 acidentes com o recurso da fabricante.

A ferramenta possui uma “expansão” de direção autônoma, o FSD, que teve seu beta liberado para todos os usuários — basta pagar US$ 15.000.

Apesar de seu nome ser traduzido como “direção autônoma total”, ela não é nada disso, pois exige que o motorista monitore o veículo o tempo todo. Na Califórnia, a Tesla pode ser obrigada a mudar a estratégia de venda — e ela mesmo afirma que não é uma direção totalmente autônoma.

Para essa tecnologia, a principal definição vem da Associação de Engenheiros Automotivos (SAE, em inglês), que a divide em cinco níveis. A FSD da Tesla está mais próxima do nível 2, já que exige uma supervisão humana. O nível 5 para o consumidor segue bem distante, independente da fabricante.

Com informações: Tech Crunch e Engadget