Slack é acusado de treinar IA com chat privado, mas diz que não é bem assim

Políticas de uso do Slack davam a entender que mensagens privadas de usuários poderiam ser usadas para treinar IAs; empresa negou prática

Políticas de uso do Slack davam a entender que mensagens privadas de usuários poderiam ser usadas para treinar IAs; empresa negou prática

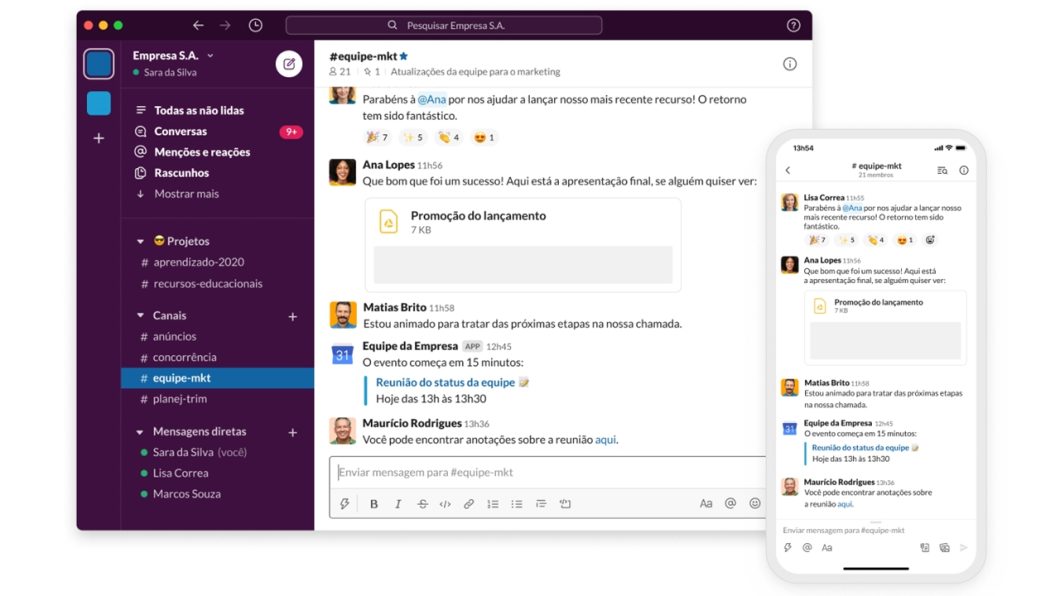

O Slack é uma das mais conhecidas plataformas de comunicação corporativa do mercado. Mas essa popularidade pode ser afetada por causa de uma polêmica: a acusação de que o serviço usa mensagens privadas de usuários para treinar a sua tecnologia de inteligência artificial (IA). A empresa soltou uma nota para se explicar.

Essa história ganhou força no Threads, depois que o engenheiro de software Gergely Orosz analisou os termos de uso do Slack e encontrou ali diretrizes que permitem que os conteúdos gerados pelos usuários em conversas privadas sejam usados para treinamento de grandes modelos de linguagem (as chamadas LLMs).

Aaron Maurer, engenheiro do Slack, explicou a Orosz que o serviço não treina LLMs com dados de clientes, mas reconheceu que as políticas da plataforma precisam ser atualizadas para deixar claro como a companhia lida com a privacidade do usuário no âmbito da IA.

Orosz não ficou convencido: “acreditarei que essa é a política quando isso estiver na política”. O assunto repercutiu rapidamente, com discussões no X/Twitter e no Hacker News, por exemplo.

Além da política que dá abertura para uso de dados privados no treinamento de IA, usuários se queixam de que não teriam sido notificados pelo Slack sobre essa mudança, fazendo com que ela fosse aceita como padrão sem o conhecimento deles.

O Slack publicou uma nota para explicar como usa dados do usuário em mecanismos de aprendizagem de máquina e inteligência artificial. A empresa também afirma ter atualizado seus termos sobre privacidade para deixar esses aspectos mais claros.

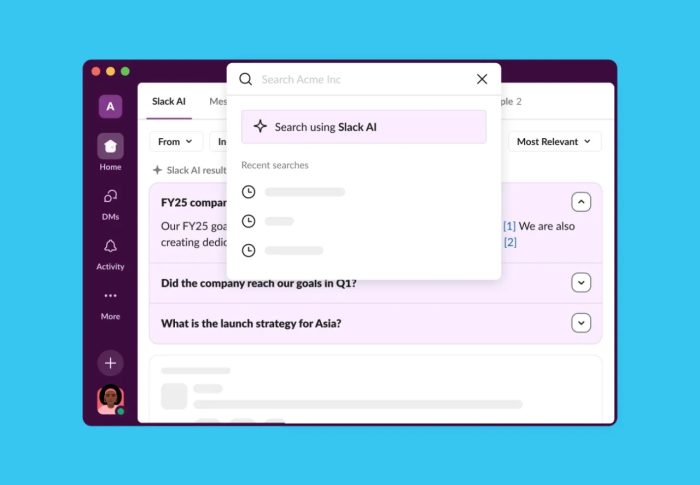

Em linhas gerais, a companhia afirma que usa dados agregados e não identificados para aperfeiçoar seus serviços, como melhorar resultados de pesquisas ou fazer recomendações de canais mais precisas.

No âmbito da IA, o Slack explicou que utiliza LLMs de terceiros para complementar o Slack AI, tecnologia que ajuda o usuário a organizar informações na plataforma. A companhia afirma que esses LLMs não são treinados com dados de usuários e que seus provedores não têm acesso a essas informações.

O Slack também afirma que não treina modelos de aprendizagem de máquina “de forma que lhes permita aprender, memorizar ou reproduzir dados de clientes”.

A empresa complementa afirmando que esses modelos não acessam diretamente mensagens ou arquivos de usuários, mas que, em vez disso, utiliza “características numéricas cuidadosamente derivadas”.

Embora o Slack tenha tratado de responder rápido às indagações dos usuários e reconhecido a necessidade de atualizar suas políticas, a polêmica não termina por aí.

Um exemplo vem da possibilidade de o usuário manifestar a vontade de que seus dados, mesmo que anônimos, não sejam usados em IA ou aprendizagem de máquina. Essa opção existe, mas só pode ser solicitada pelo administrador da organização que usa o Slack, não por usuários individuais.

Além disso, essa questão faz parte de uma discussão maior, que envolve praticamente todas as organizações que desenvolvem ou treinam LLMs: o uso pouco claro de dados de terceiros para treinamento desses mecanismos.

Vide o exemplo do Google, que já mostra resultados de buscas com IA generativa nos Estados Unidos. Muitos editores de sites têm criticado a empresa por gerar resumos nesses resultados com base no conteúdo de suas páginas, mas não recebem nenhuma compensação por isso e, pior, muitas vezes deixam de receber o acesso do usuário que buscou aquela informação.

Leia | Como funciona o Rocket.Chat [alternativa de código aberto ao Slack]