Um professor está fazendo as perguntas certas sobre carros autônomos

Chris Gerdes levanta questões éticas que o próprio Google ainda não conseguiu resolver

Chris Gerdes levanta questões éticas que o próprio Google ainda não conseguiu resolver

Enquanto o Google admite que seus carros são seguros demais, Chris Gerdes, professor da Universidade de Stanford, na Califórnia, está interessado em resolver questões éticas dos veículos que andam sozinhos. O problema é semelhante ao do Google: como eles devem agir em situações que requerem um pouco mais de tolerância, naturais para os humanos, mas inaceitáveis para robôs?

Gerdes é um entusiasta de carros autônomos há algum tempo. Em uma palestra que fez no TEDxStanford, ele mostra Shelly, nome que deu a um carro modificado da Audi que chega a 240 km/h (e sem motorista algum). Shelly chegou a fazer as 153 curvas na estrada de quase 20 km de extensão do Pico Pikes, uma montanha que também é usada para A Corrida às Nuvens, competição anual de automobilismo.

A ideia de fazer as perguntas certas veio há três anos, quando George Bekey, coautor do livro Ética dos Robôs (tradução livre) enviou um e-mail a Gerdes. Bekey apresentava seus questionamentos, que vão desde como robôs devem ser usados em guerras, questões de privacidade e até questões emocionais (olá, Her).

Depois de se debruçar sobre o assunto, Gerdes diz que a tecnologia ainda não está resolvida. Segundo ele, “há muito contexto [envolvido], várias coisas sutis, mas importantes, que precisam ser resolvidas”. Por meio de uma série de testes, ele estuda como programar um robô para, eventualmente, infringir a lei ou tomar decisões éticas mais complexas.

Por exemplo: em uma rua isolada, Gerdes colocou uma série de cavaletes e cones de trânsito para simular uma construção que toma toda a pista ocupada pelo carro autônomo. Ao lado do veículo, há uma faixa amarela contínua (pela lei, só é permitido atravessar na faixa tracejada). O que o carro deve fazer? Infringir a lei e desviar da construção?

Sim, nesse caso é óbvio. No entanto, o carro tomou a decisão no último segundo, quase atropelando os cones. Tudo bem, o veículo poderia ser reprogramado para trazer mais eficiência quando ele se encontrar em uma situação parecida, mas e se houvesse uma maior complexidade na decisão que ele tem que tomar?

Imagine que há um acidente que o carro não pode evitar, como um grupo de pedestres (incluindo uma mãe com um carrinho de bebê) que atravessou no sinal vermelho em uma pista de velocidade relativamente alta. O carro não consegue brecar a tempo, então o que ele deve fazer? Atingir o menor objeto, que pode ser um carrinho de bebê ou de supermercado? Fazer uma curva brusca e arriscar a vida do motorista? A vida de quem deve ser priorizada: do motorista ou dos pedestres?

Esses são dilemas que alguns motoristas já podem ter enfrentado ― e decisões foram tomadas no calor do momento. Caso aconteça alguma tragédia, é possível até que o motorista não seja condenado porque talvez ele não tenha tido tempo o suficiente para pensar na decisão mais adequada. Com um robô essa desculpa não funciona.

No final, isso se resume a torná-los mais autônomos. Não apenas para dirigir, mas para serem capazes de tomar decisões difíceis e agir como um humano — usando os artifícios da tecnologia de robôs. Gerdes defende que precisamos pensar sobre como as leis de trânsito refletem o comportamento real dos motoristas, para “evitar colocar o programador em uma situação de decidir o que é seguro frente ao que é legal”.

Esse fundamento vem de mais longe do que você imagina: na década de 50, o escritor russo Isaac Asimov produziu uma série de livros de ficção científica que até hoje são referência para a ética de robôs. Asimov dizia que uma máquina autônoma não pode ferir um ser humano ou, por inércia, permitir que um humano seja ferido.

Até o próprio Google, que está desenvolvendo carros autônomos há anos, está se complicando nessas questões. Seus carros, por seguirem à risca as leis de trânsito, acabam sendo “seguros demais”. Há uma cautela excessiva, principalmente em cruzamentos, que acabam fazendo com que os carros irritem outros motoristas.

É por isso que o Google está treinando seus carros autônomos a lidarem com imprevistos. Muitas vezes, isso se resume a reduzir a velocidade para que mais informações sobre a situação estejam disponíveis. O problema é que nem sempre isso acontece: a própria gigante de Mountain View já disse em um relatório que eles imaginaram uma situação de um ciclista entrar na frente do carro sem ser detectado porque ele surgiu no meio de dois veículos estacionados, por exemplo.

A própria Tesla, comandada pelo visionário Elon Musk, entra com cautela nesse mundo de carros autônomos. Quem comprou um Model S a partir de setembro já pode atualizar o software do seu carro e tornar algumas etapas da direção automáticas (!). Os recursos cobrem desde guiar o carro pela faixa atual, mudança de faixa e até estacionamento automático. Musk, no entanto, pede para que as pessoas sejam cuidadosas e recomenda que elas não tirem a mão do volante em momento algum.

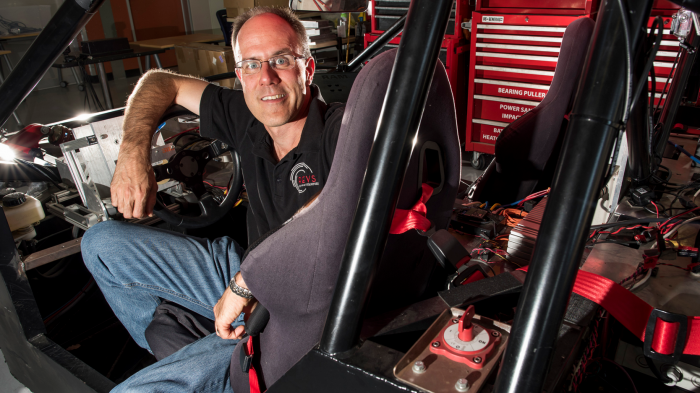

Enquanto empresas gigantes têm equipes dedicadas à pesquisa e desenvolvimento de veículos sem motoristas, Gerdes trabalha em uma garagem com transmissões doadas pela Ford e um motor elétrico dado pelo próprio Google. Seus alunos e outros parceiros especializados nessa indústria chegam a trabalhar para grandes montadoras, como a Volkswagen. Uma vez por mês, ele e sua equipe testam esses carros na pista Thunderhill Park em condições extremas.

“Como qualquer tecnologia nova, há um pico de hype e depois um banho de desilusão”, diz. “Nós estamos em algum lugar desse pico de hype agora. Os benefícios são reais, mas nós podemos ter um vale à nossa frente antes de vermos os benefícios dessa tecnologia que transforma a sociedade”, completa.

Com informações: Bloomberg