Sites prometem dedurar textos criados por IAs, mas raramente conseguem

Plataformas analisam textos para verificar se foram escritos por IAs; dos sete sites acessados durante os testes, somente dois tiveram um resultado promissor

Plataformas analisam textos para verificar se foram escritos por IAs; dos sete sites acessados durante os testes, somente dois tiveram um resultado promissor

Com o sucesso do ChatGPT, uma preocupação veio à tona: como identificar textos que foram criados por inteligência artificial (IA)? Seja pela plataforma da OpenAI ou por outras soluções, ficou bem mais fácil encontrar conteúdos gerados por estes sistemas nos últimos tempos. Diante disso, alguns sites vieram a público para responder esta questão, mas ainda não conseguem ajudar muito.

O testemunho parte de uma análise do TechCrunch nesta quinta-feira (16). Para verificar a confiabilidade desses sistemas, o site especializado criou oito exemplos em estilos diferentes. Esses conteúdos foram gerados pelo sistema Claude, desenvolvido pela startup Anthropic.

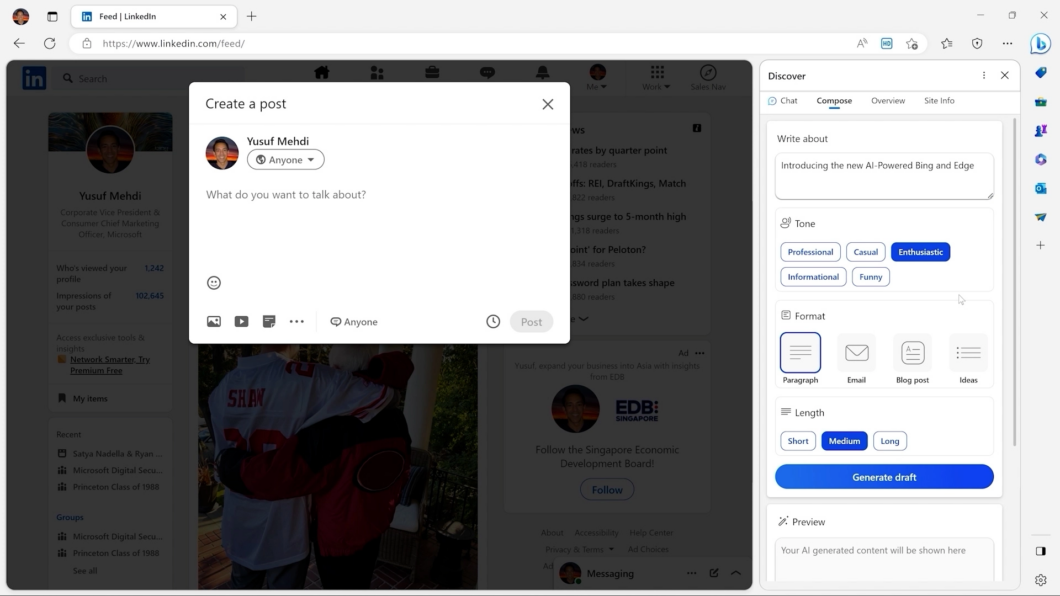

Em seguida, os textos foram levados a sites que prometem dedurar textos criados por IAs: o verificador da própria OpenAI, AI Writing Check, GPTZero, Copyleaks, GPT Radar, CatchGPT e Originality.ai.

O problema é que nenhum desses sistemas funcionou muito bem.

O primeiro exemplo traz uma citação de enciclopédia sobre a Mesoamérica. No entanto, somente o GPTZero e o Originality.ai perceberam que se tratava de uma publicação escrita por uma inteligência artificial.

Na sequência, o site utilizou um email marketing sobre polimento de sapatos, entupido de passagens engraçadas e chamativas, para a verificação. Dessa vez, nenhum sistema acusou o embuste.

A terceira tentativa envolveu um ensaio universitário sobre a queda de Roma. Este exemplo merece um pouco de destaque, pois indica se os professores terão dificuldades para identificar se os alunos estão utilizando essas ferramentas para fazer as suas atividades.

Dessa vez, o CatchGPT apurou que a possibilidade de o texto vir de uma IA era de 99,9%. O GPTZero também conseguiu identificar que o ensaio não foi escrito por um humano. Mas os demais, novamente, não encontraram problemas no conteúdo.

O mesmo é dito a um esboço de ensaio: apenas a ferramenta da OpenAI, o GPTZero e o CatchGPT indicaram que havia chances de o conteúdo ser produzido por uma inteligência artificial.

Além dos trabalhos acadêmicos, existe a preocupação em relação às notícias. Especialmente depois da polêmica envolvendo as publicações feitas por IA pelo portal CNET, conforme apontado pelo The Verge. Por isso, a galera do TechCrunch usou o sistema da Anthropic para criar uma notícia sobre a eleição presidencial dos Estados Unidos de 2020.

E adivinha? Quase todos os sites erraram, com exceção do GPTZero.

Os resultados foram similares em outros exemplos, como uma carta de apresentação para uma posição de paralegal, currículo de um engenheiro de software e um esboço de um ensaio sobre os méritos do controle de armas. Após a análise de oito exemplos, este foi o placar dos sistemas:

No fim das contas, somente o GPTZero e o CatchGPT se saíram bem na análise. Todavia, ainda se trata de um resultado bem aquém do esperado, mantendo em aberto a dificuldade para verificar quais textos foram, de fato, gerados por IA. Ou seja, mesmo com cerca de 50% de acerto, não dá mesmo para utilizá-los com olhos fechados.

Mas isto não significa necessariamente que esses conteúdos criados por inteligência artificial são completamente corretos, isentos de falhas e similar aos textos escritos por humanos. Diferentemente das ferramentas para analisar casos de plágio, esses sistemas não procuram similaridades. Pelo contrário, a busca por padrões.

Conforme explicado pelo TechCrunch, esses sistemas de detecção são treinados com textos disponíveis na internet e em outras fonte para compreender a diferença entre conteúdos feitos por humanos e por sistemas de IA. E aí vem a grande questão: os chatbots e afins estão sendo aperfeiçoados constantemente, dificultando o serviço desses sites.

E tem outro problema: essas plataformas de verificação podem trazer limitações técnicas. Ou seja, além de não ser eficaz, será que estão prontos para verificar um livro inteiro? E se um professor quiser verificar os relatórios de pesquisa de uma turma inteira? Ele vai conseguir?

Claro, os serviços podem evoluir no futuro. Todavia, essas perguntas permanecem válidas para o futuro. Afinal, se até hoje as ferramentas de detecção de plágio não são completamente precisas, quem dirá sobre os sistemas para verificar se um conteúdo veio de uma IA ou não?

Com informações: TechCrunch