ChatGPT e outras IAs mentem que nem sentem — e a gente acredita

Respostas geradas por IAs passam tanta convicção que erros e dados falsos não são percebidos; textos produzidos por essas tecnologias já causaram problemas no CNET

Respostas geradas por IAs passam tanta convicção que erros e dados falsos não são percebidos; textos produzidos por essas tecnologias já causaram problemas no CNET

O site CNET teve que se retratar em publicações sobre investimento pois a IA usada para gerar as notícias estava errando o resultado de cálculos — e o veículo também omitiu a informação de que estava gerando notícias através de uma IA. O problema não é só o erro, mas o texto soava convincente sobre o lucro.

Isso é um exemplo de como as inteligências artificiais que geram textos com base em perguntas ou “ordens” de humanos possuem um grave problema: a convicção com a qual produzem uma resposta. Cada vez mais popular, o assunto de IAs como o ChatGPT auxiliando em questões começa a trazer problemas por passarem respostas erradas mas com muita confiança sobre o assunto — ou apenas em um texto bem estruturado.

A “lábia” e a confiança no que se fala é um dos fatores usados por golpistas para aplicar seus crimes. Vide o caso de Frank Abagnale Júnior, cuja história inspirou o filme Prenda-me se For Capaz. Porém, uma IA (até onde sabemos) não tem a malícia de querer enganar alguém propositalmente. Parafraseando o Craque Daniel: a tecnologia de IA erra com convicção.

No caso da CNET, o texto explicava o cálculo de um investimento de 3% ao ano. No exemplo, a IA dizia que ao investir US$ 10.000, o lucro seria de US$ 10.300.

Na verdade, o lucro é de US$ 300.

Para ganhar US$ 10.300 no ano com um investimento de US$ 10.000, o juros deveria ser de 103%.

O erro é detectável por um leitor com conhecimento de finanças, mas quem não é muito fã de números pode sofrer com isso, deixando de fazer um investimento maior por ter confiado em um texto de IA que explicava errado — sem saber que o autor é um robô.

Aqui entramos em outro problema: o CNET não informava que estava usando IAs para alguns textos. O autor aparecia apenas como “Equipe de Finanças do CNET”. Agora, o site informa que o texto é produzido por um robô e revisado por um humano.

E esse não foi o único problema de uma IA errando com confiança. No tweet abaixo, o @FEhrsam comenta como o ChatGPT deu uma resposta mais precisa e “concisa” sobre o cálculo de ritmo de corrida. Porém, ele é corrigido por outro usuário explicando que o ChatGPT errou e que a conta certa é a do Google. Infelizmente, não temos mais o tweet original para ver qual era a conta.

Porém, testei o ChatGPT com uma regra de três composta. O problema, pego da Wikipédia em inglês, era o seguinte:

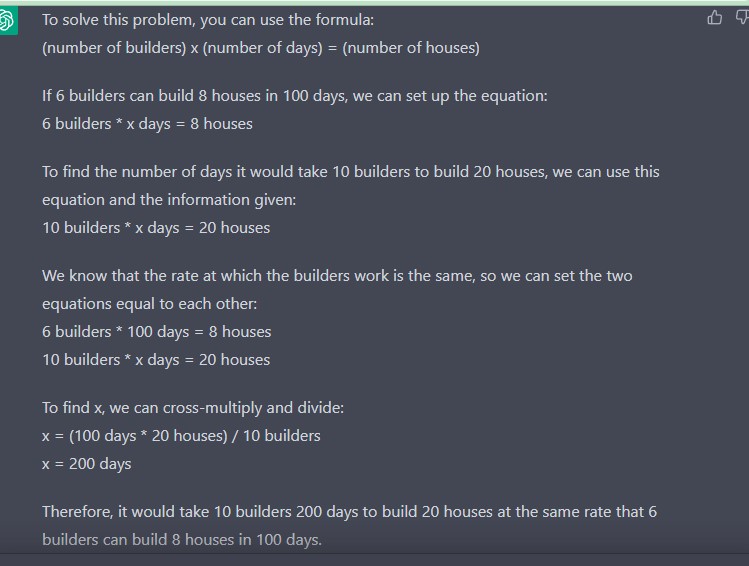

Se 6 pedreiros constroem 8 casas em 100 dias, 10 pedreiros constroem 20 casas em quantos dias na mesma “eficiência”? O resultado é 150 dias. Como eu pensei, o ChatGPT teria problemas com esse tipo de conta. Por algum motivo, ele até fez um raciocínio correto, mas ignorou um dos fatores na sua conta e deu como resultado 200 dias.

O uso de inteligência artificial no jornalismo (no meu ver) não é prejudicial para a profissão, mas em alguns casos a “responsabilidade do erro” precisa ser de um humano — como no caso de textos sobre investimentos, onde você pode influenciar leitores a usarem seu próprio dinheiro de alguma maneira.

Em outros casos, a IA pode acabar facilitando a produção de um veículo de notícias. Um exemplo disso são em coberturas eleitorais. Nem toda redação de um jornal ou site terá o tempo livre para escrever o resultado de todas as eleições municipais.

Em 2020, o G1 usou uma IA para escrever as notícias sobre os resultados de todas as prefeituras. A tecnologia buscava os dados do site do TSE e era capaz de escrever um texto “mecanizado”, informando o vencedor, partido, porcentagem e o segundo colocado.