OpenAI quer usar IA para ajudar humanos que treinam IA

CriticGPT consegue achar erros em códigos de programação gerados pelo ChatGPT, ajudando treinadores a "ensinar" a ferramenta

CriticGPT consegue achar erros em códigos de programação gerados pelo ChatGPT, ajudando treinadores a "ensinar" a ferramenta

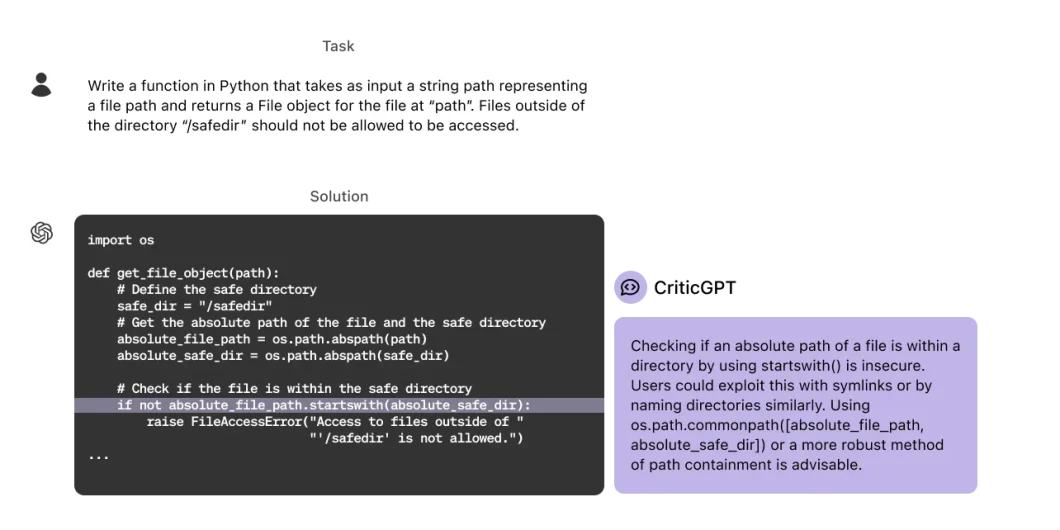

A OpenAI revelou um novo modelo de inteligência artificial chamado CriticGPT. Ele é baseado no GPT-4, mas com outra especialidade: encontrar erros em códigos gerados pelo ChatGPT. A ideia é que ele ajude humanos na tarefa de treinar modelos de IA.

Pode parecer estranho, mas a empresa explica: seus modelos são treinados usando uma técnica chamada aprendizado por reforço com feedback humano (ou RLHF, na sigla em inglês). Nesta técnica, humanos avaliam as respostas dadas por modelos de IA. A ideia é aperfeiçoar o modelo, para que os resultados sejam mais úteis em situações reais e mais próximos ao desejado por humanos.

Quando o ChatGPT gera um código, estes humanos, chamados treinadores de IA, revisam a resposta e apontam os erros, para que o modelo “aprenda” o que fazer. O problema é que humanos também podem errar e não perceber o que está incorreto em uma resposta.

O CriticGPT pode ajudar nisso. A ferramenta encontra erros nos códigos gerados pelo ChatGPT e escreve uma crítica (daí seu nome) explicando o problema.

Segundo a OpenAI, treinadores de IA preferiram as críticas feitas por outros treinadores com ajuda do CriticGPT em 60% dos casos, em comparação com críticas feitas apenas por humanos.

A empresa diz que a “parceria” resulta em avaliações mais compreensivas dos que as feitas apenas por humanos e em menos alucinações que as feitas só pela IA.

Um ponto curioso é que o próprio CriticGPT foi desenvolvido usando RLHF. Os treinadores de IA colocaram manualmente erros em códigos criados pelo ChatGPT e escreveram avaliações como explicando os problemas, como se tivessem sido descobertos por eles.

Depois, estes funcionários verificavam várias avaliações feitas pelo CriticGPT e escolhiam a melhor, como forma de reforçar para o modelo o que ele deveria fazer.

O próprio ChatGPT poderia ser usado para avaliar os códigos, mas o modelo especializado se sai melhor na tarefa. Treinadores de IA consideraram a crítica do CriticGPT melhor que a do ChatGPT em 63% dos casos. Para eles, a nova IA produz menos reclamações inúteis e menos alucinações.

Apesar das vantagens, o CriticGPT não é perfeito. A OpenAI admite que ele também pode alucinar, levando os treinadores a cometer erros. Além disso, o modelo foi treinado com respostas curtas e códigos com apenas um erro — para tarefas mais complexas, novos métodos serão necessários.

Com informações: OpenAI, Ars Technica