O que é HDR (High Dynamic Range)?

Entenda as diferenças entre o uso de HDR na TV e o HDR da fotografia, presente em câmeras de celular

Entenda as diferenças entre o uso de HDR na TV e o HDR da fotografia, presente em câmeras de celular

HDR significa High Dynamic Range. Essa tecnologia é usada em TVs, monitores, celulares e câmeras para reproduzir maior gama de cores e nível de contraste, resultando em uma imagem mais realista.

O HDR em TVs e monitores utiliza metadados para aumentar o contraste entre áreas claras e escuras, exibir maior brilho e reproduzir um volume de cor mais amplo do que na faixa dinâmica padrão (SDR), melhorando a qualidade da imagem.

Metadados

Os metadados são informações embutidas no conteúdo em HDR que ajudam o dispositivo a determinar as configurações de imagem mais adequadas.

Tecnologias antigas, como o HDR10, trabalham com metadados estáticos, ou seja, o mesmo brilho e contraste é usado durante todo o filme ou episódio de uma série.

Já o HDR10+ e o Dolby Vision têm metadados dinâmicos, por isso, as cenas mais escuras de um filme são reproduzidas com um pico de brilho menor, enquanto as mais claras podem ter brilho mais alto.

O tipo de painel pode afetar o desempenho do HDR. Telas OLED geralmente são superiores por terem alta taxa de contraste, já que cada pixel emite sua própria luz e pode ser “desligado” para exibir o preto verdadeiro. A mesma vantagem pode ser encontrada no MicroLED.

Painéis LCD, por outro lado, dependem de um backlight mais avançado e técnicas como local dimming para melhorar o contraste. Essas características são superiores em telas de cristal líquido com iluminação em MiniLED, como nas linhas Samsung Neo QLED e LG QNED MiniLED.

Para uma boa experiência com HDR, um monitor ou TV deve suportar ampla gama de cores e ter alto nível de brilho, medido em nits, para aumentar o alcance dinâmico da imagem. Além disso, a tela precisa ser compatível com cabos HDMI 2.0a ou mais recentes para exibir conteúdos em HDR de um dispositivo externo.

É possível encontrar conteúdos em HDR na Netflix e várias outras plataformas de streaming, como YouTube, Amazon Prime Video e Disney+. Filmes em Blu-ray 4K Ultra HD também podem conter HDR e são reproduzidos em dispositivos como PlayStation 5 e Xbox Series X.

Nosso comparativo mostra as diferenças entre os tipos de HDR existentes. De forma resumida, temos os seguintes padrões na indústria:

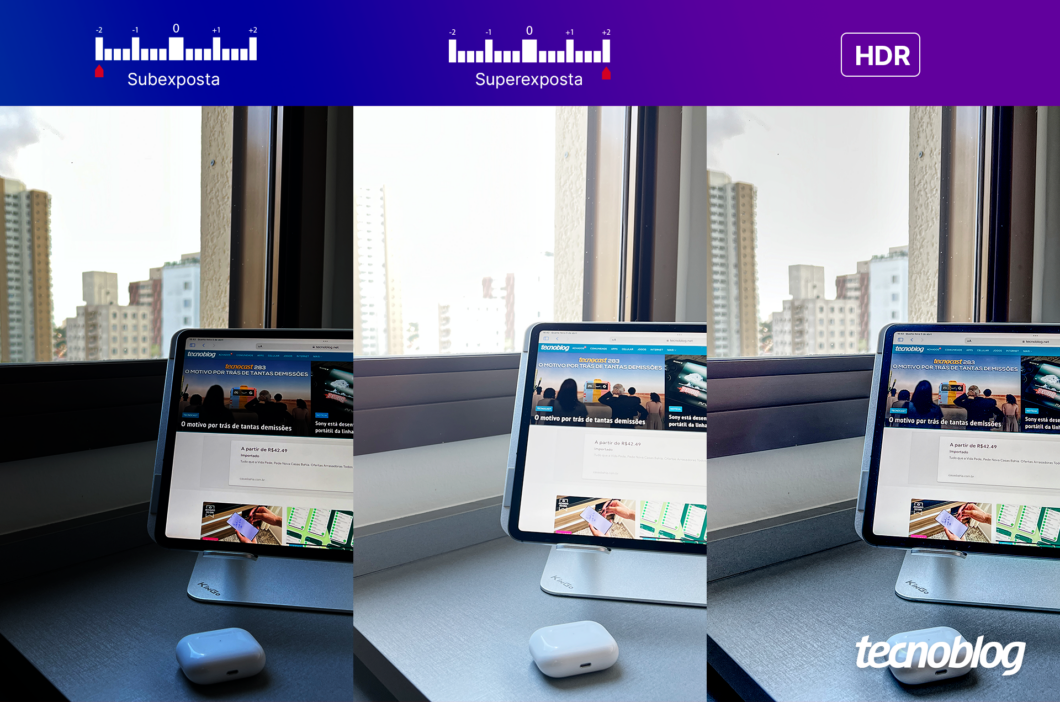

O HDR para câmeras funciona por meio de um software que combina diferentes exposições da mesma imagem para obter uma foto com maior alcance dinâmico. Em termos práticos: a câmera tira várias fotos com diferentes configurações de luminosidade e contraste, e depois as mescla em uma única imagem.

O processo ajuda a equilibrar as áreas mais escuras e claras da foto, resultando em uma imagem mais realista. Ele também pode ser útil em situações de alta luminosidade e contraste, como em fotos de ambientes internos com janelas, para balancear a luz externa e a interna, evitando regiões “estouradas”.

Celulares de todas as faixas de preço costumam ter modo HDR, mas nem todos oferecem a mesma qualidade. Isso ocorre porque sensores de câmeras mais caros tendem a suportar maior alcance dinâmico, enquanto os mais baratos dependem mais do software para criar uma foto com HDR.

A quantidade de exposições diferentes que a câmera é capaz de capturar também influencia na qualidade do HDR. Algumas podem tirar apenas duas ou três fotos para criar o HDR, enquanto outras podem capturar cinco ou mais. Quanto mais níveis de exposição a câmera capturar, mais informações de luz e sombra serão usadas pelo software.

O modo HDR deve ser utilizado em situações com alto contraste e diferença de luminosidade, como em paisagens com céu claro e áreas sombreadas.

No entanto, o HDR pode não ser adequado para fotografar objetos em movimento, pois a combinação de várias exposições na mesma foto pode resultar em uma imagem borrada. Além disso, em situações de baixa luminosidade, o HDR pode gerar fotos com mais ruído.

Para obter os melhores resultados com o modo HDR, é recomendado o uso de um tripé e um cenário estático, o que evitará tremores e borrões. Além disso, algumas câmeras permitem ajustar as configurações do HDR, para personalizar a quantidade de exposições diferentes e a intensidade do efeito.

4K refere-se à resolução da imagem, enquanto HDR está relacionado ao contraste, brilho e cores. Ambas as tecnologias podem trabalhar juntas para oferecer uma melhor qualidade de imagem.

Para suportar HDR, é necessário um cabo HDMI que suporte pelo menos 10,2 Gb/s de largura de banda. Idealmente, é recomendado um cabo HDMI 2.0 ou superior. Alguns cabos HDMI 1.4 também podem suportar HDR, mas com limitações de resolução e taxa de atualização.